Ultrakrótka historia elektroniki

W poniższym artykule skrótowo przedstawiona jest historia elektroniki z uwzględnieniem kluczowych „kamieni milowych” w jej rozwoju – od archaicznych radioodbiorników do współczesnych smartfonów. Na życzenie Czytelników dowolne ze wspomnianych tu zagadnień mogą być omówione dokładniej. Zasadniczo można stwierdzić, że dobrodziejstwa elektroniki zaczęły być dostępne dla ludzkości dopiero w XX wieku i że należy to wiązać z wynalezieniem lampy elektronowej. Jak najbardziej, ale odkrycia, które są podstawą elektroniki zostały dokonane znacznie wcześniej.

Początek ery elektryczności – rok 1800

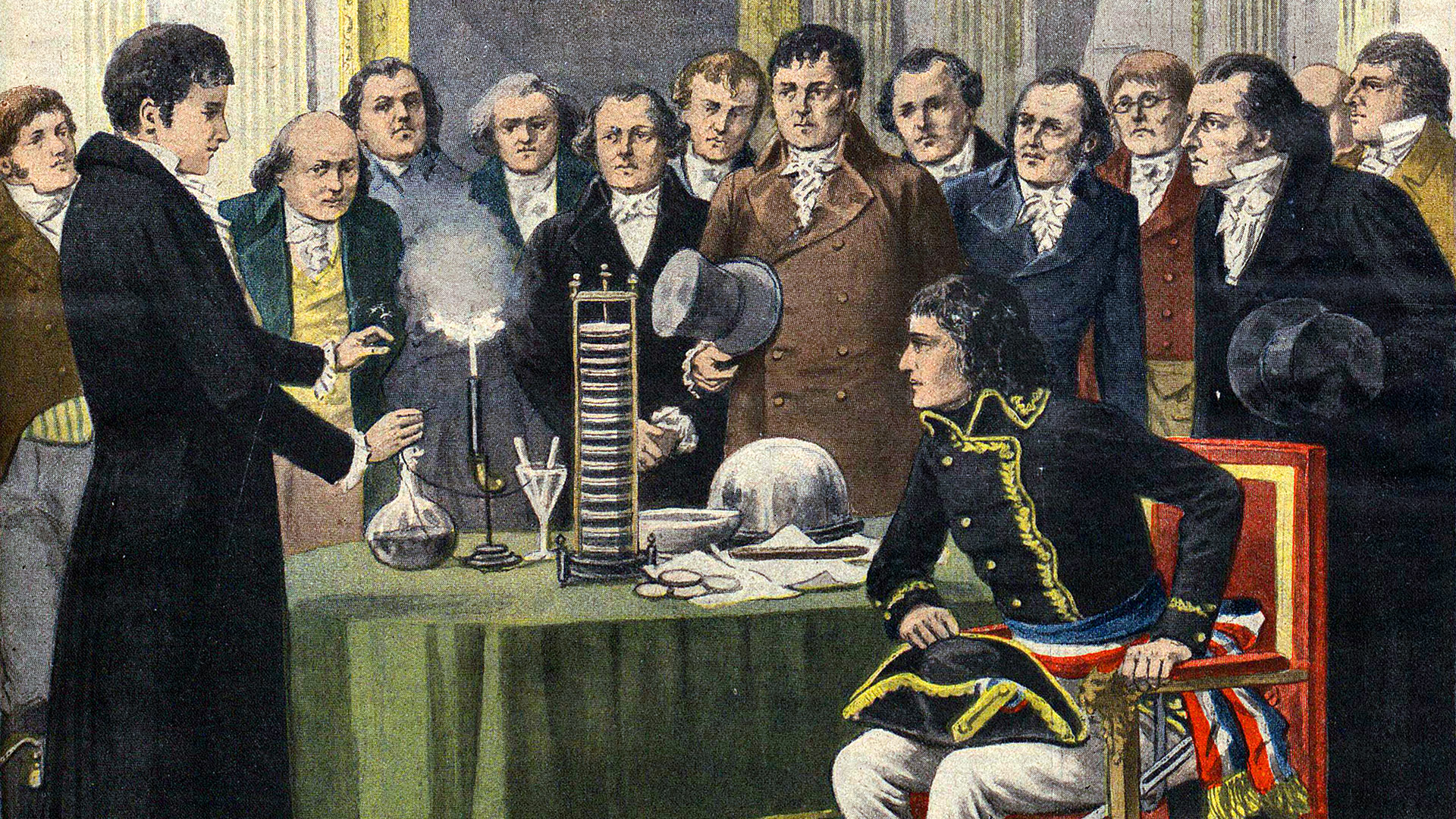

Łatwo zapamiętać, że odkrycie, które umożliwiło powstanie i rozwój elektroniki zostało dokonane w roku 1800 – wtedy Alessandro Volta wynalazł rodzaj baterii elektrycznej (stos Volty). Rysunek wstępny pokazuje prezentację swojego wynalazku, jaką hrabia Volta przedstawił Napoleonowi.

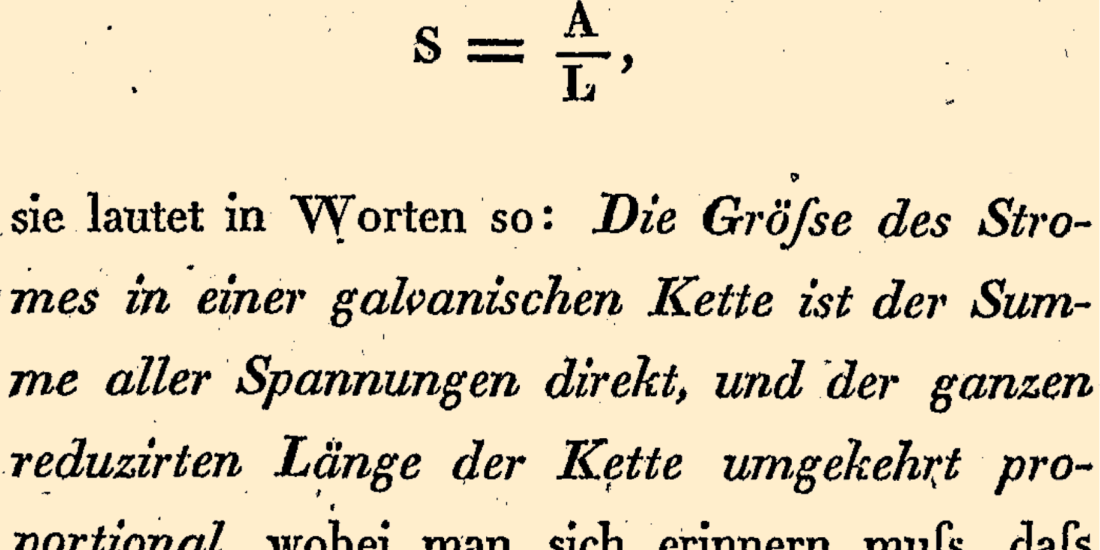

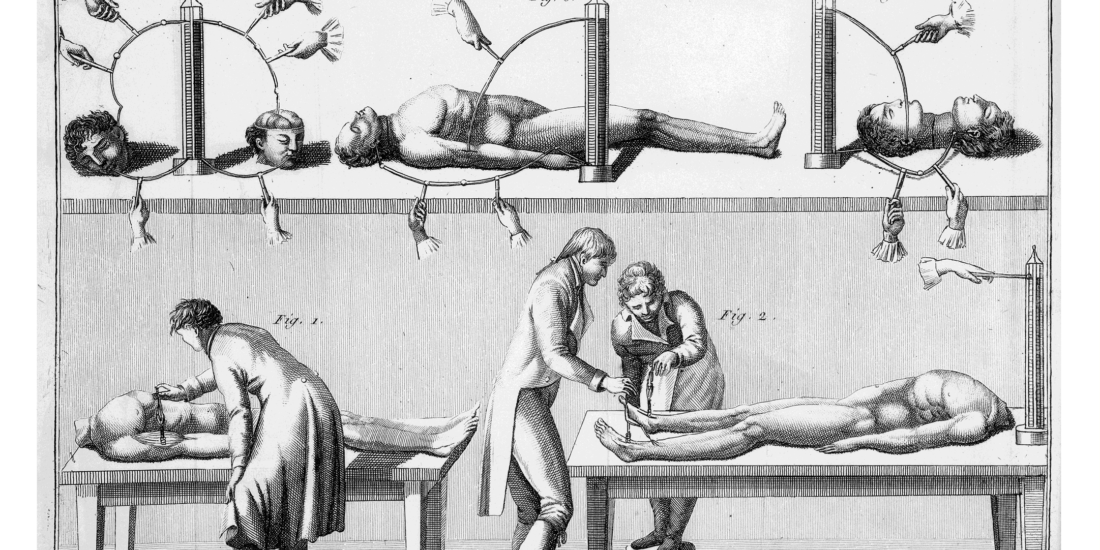

Wcześniej badano tylko tak zwaną elektryczność statyczną, która była jedynie jarmarczną ciekawostką. Dopiero bateria Volty otworzyła drogę do badań nad zjawiskami elektrycznymi dla mnóstwa badaczy, w tym najbardziej znaczących jak Michael Faraday, Andre Marie Ampère, Hans Christian Ørsted oraz Georg Simon Ohm.

Wyniki ich eksperymentów z lat 1820…1860 były z kolei materiałem, „surowcem” dla teoretyka Jamesa Clerka Maxwella, który około roku 1865 przedstawił interesujący, ale skomplikowany i trudny do zrozumienia matematyczny opis zjawisk elektryczności i magnetyzmu. Co ważne, teoretyk Maxwell przewidział też istnienie fal radiowych, które odkrył dwadzieścia lat później (1886) młody, dobrze się zapowiadający naukowiec Heinrich Hertz.

Początek ery elektroniki – rok 1900

Początki elektroniki należy wiązać z radiem. Tu przypomina się więc wynalazca radia – Nikola Tesla oraz sprytny przedsiębiorca Guglielmo Marconi, który właśnie na przełomie XIX i XX wieku przeprowadzał praktyczne próby radiowej transmisji sygnałów telegraficznych, co można uznać za początek wykorzystania radia i początki elektroniki.

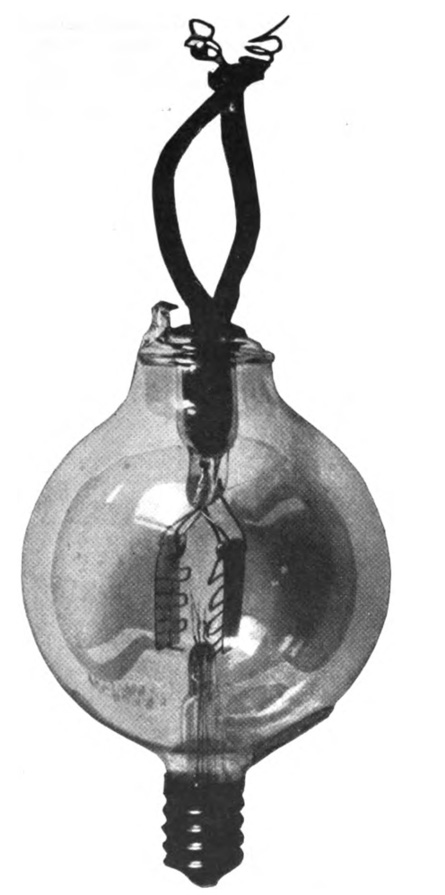

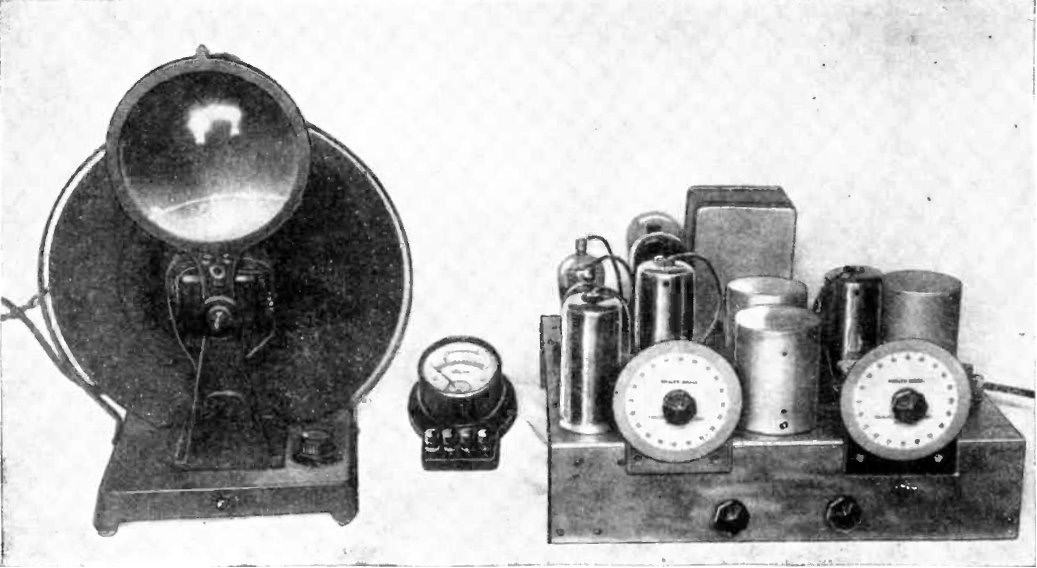

Kamieniem milowym było wynalezienie w roku 1907 (Lee de Forest) próżniowej lampy elektronowej, triody zwanej audionem, która pozwalała wzmacniać sygnały elektryczne. Po Wielkiej Wojnie, od lat 20. XX wieku rozpoczął się gwałtowny rozwój radia czyli przekazu głosu na odległość – urządzenia elektroniczne „trafiły pod strzechy”.

Zaskoczeniem może być informacja, że pierwsza publiczna demonstracja bardzo prymitywnej telewizji, czyli przekazu obrazu na odległość, miała miejsce już w roku 1900 podczas Wystawy Światowej w Paryżu. Tak zwana telewizja mechaniczna została opracowana już w latach 20. (John Logie Baird) i zaczęła działać w latach 30.

Całkowicie elektroniczna telewizja została opracowana przed II Wojną Światową (Philo Farnsworth, Władimir Zworykin), ale zaczęła się upowszechniać dopiero po wojnie. Wkrótce opracowano telewizję kolorową, a w latach 80 telewizję trójwymiarową (3D) i cyfrową.

Wzmacnianie i wzmacniacze

Kluczem i fundamentem rozwoju elektroniki były na początku elementy wzmacniające.

Zaskoczeniem może być fakt, że pierwszymi wzmacniaczami były mikrofony węglowe wynalezione około roku 1880, z powodzeniem wykorzystywane w telefonii przez 100 lat.

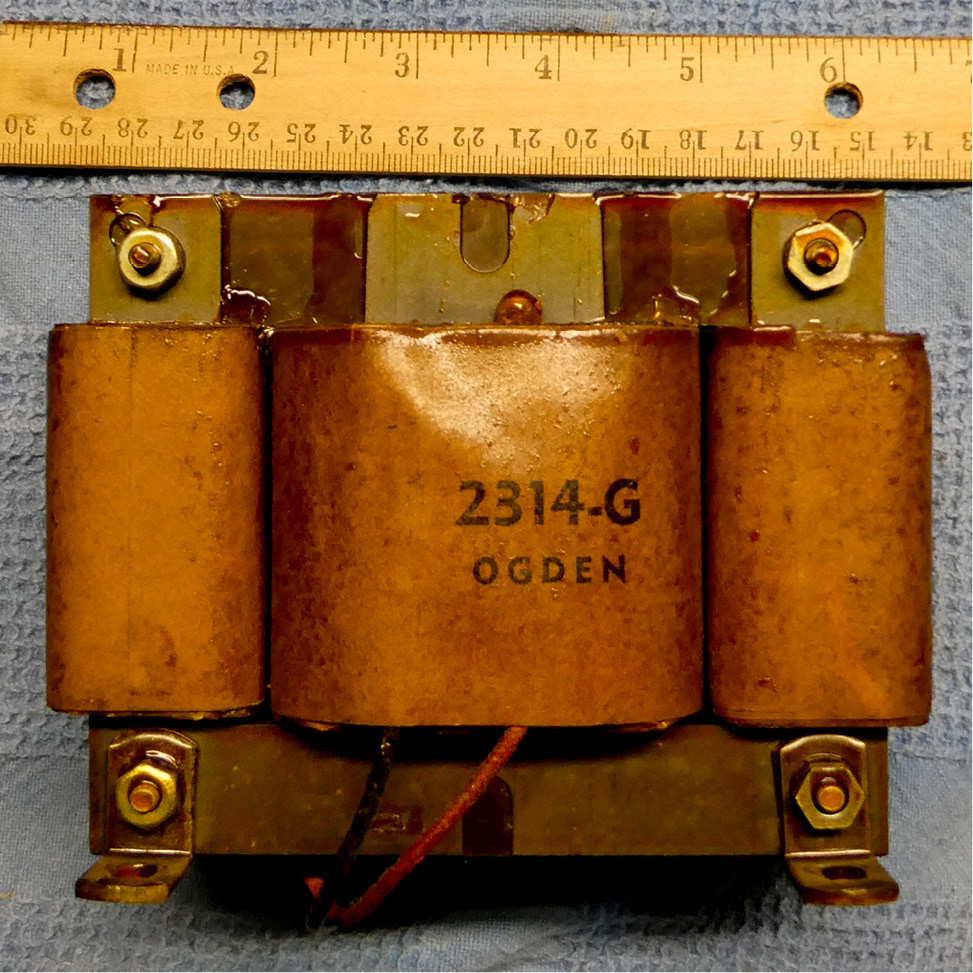

Zaskakująca może też być informacja, że w lotnictwie do niedawna wykorzystywano tak zwane wzmacniacze magnetyczne, które można uznać za specyficzny rodzaj transformatora.

Nie wszyscy wiedzą, że elementami wzmacniającymi są też niektóre diody (diody tunelowe i IMPATT).

Najbardziej znanymi elementami wzmacniającymi dawniej były lampy elektronowe, które dominowały do lat 60. XX wieku. A dziś są nimi rozmaite tranzystory. A z tranzystorów zbudowane są układy scalone.

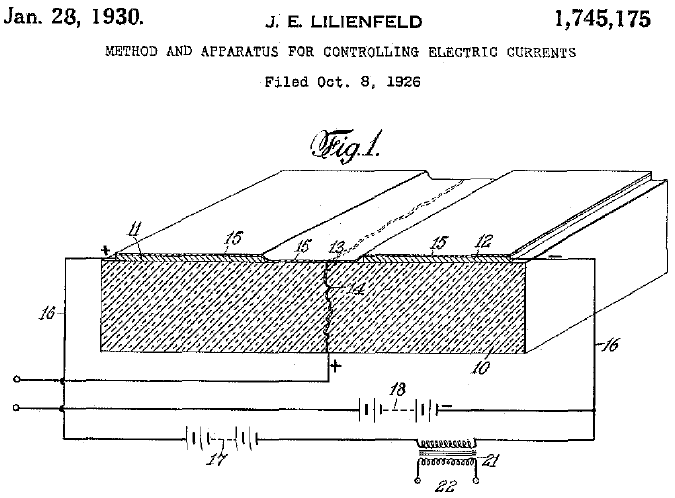

Zaskoczeniem może być fakt, że pierwszy patent na tranzystor pochodzi z roku 1930 i ma on związek z… Polską. Jednak droga od tego pomysłu do jego realizacji trwała około 30 lat.

Tak! Dominujące dziś „prawdziwe tranzystory” zostały wynalezione dopiero około roku 1960. Natomiast w grudniu 1947 nie tyle wynaleziono, tylko przypadkowo odkryto tranzystor bipolarny i był to swego rodzaju „wypadek przy pracy”. Dziś tranzystory bipolarne (NPN, PNP) mają znikome znaczenie. Niepodzielnie królują tranzystory MOSFET.

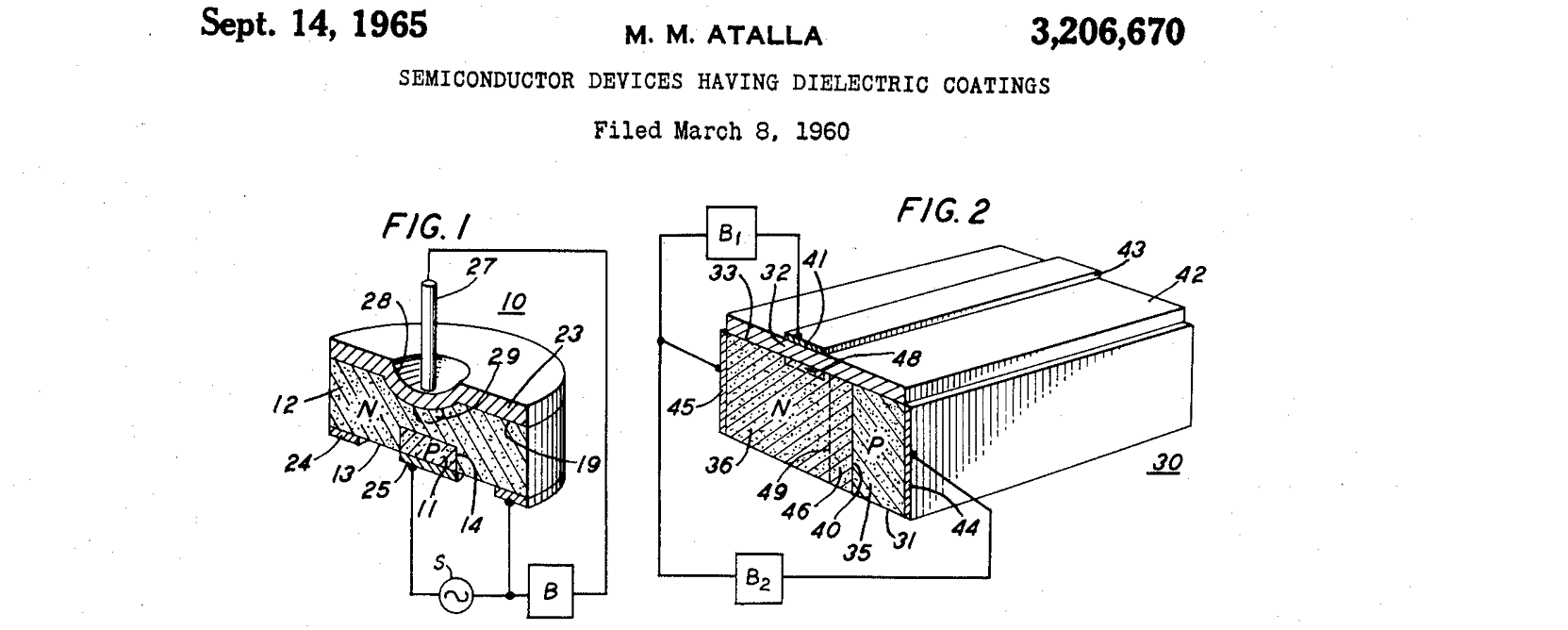

Patent na tranzystor MOSFET z roku 1960I właśnie dopiero tranzystory MOSFET, a także pokrewne tranzystory wykorzystujące efekt polowy, umożliwiły nieprawdopodobny rozwój elektroniki.

Tranzystor jest nie tylko elementem wzmacniającym. Co niezmiernie ważne, może też pracować jako zdalnie sterowany przełącznik, jako sterowany klucz, co pozwala realizować układy pełniące funkcje logiczne, arytmetyczne, czyli przeprowadzać obliczenia i przetwarzać informacje.

Komputery i mikroprocesory

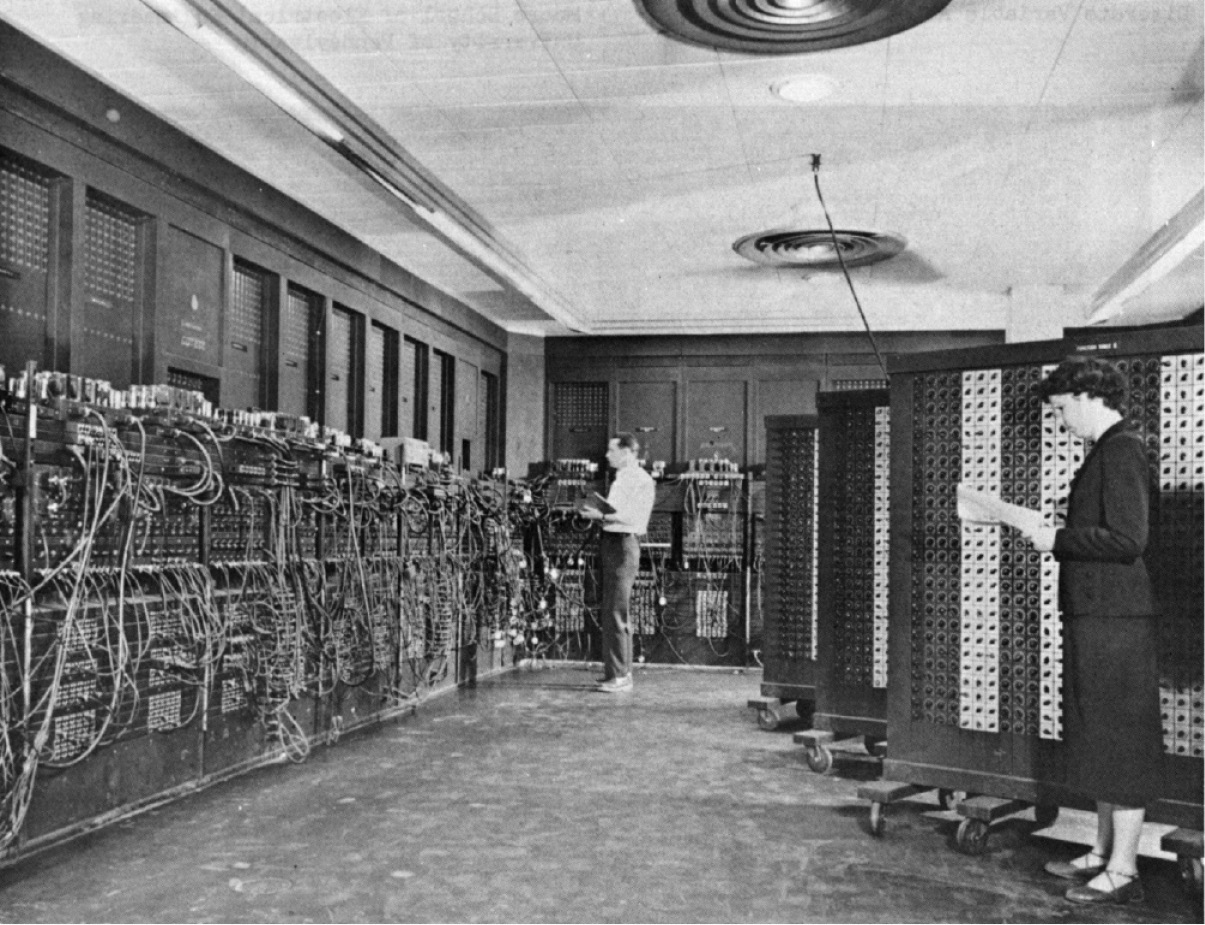

Komputery, czyli elektroniczne maszyny do obliczeń matematycznych zaczęto szerzej wykorzystywać podczas wojny, od początku lat 40. Najpierw były to mało znane komputery analogowe. Pierwszym znanym elektronicznym komputerem cyfrowym był ENIAC z roku 1945. I jedne, i drugie opierały swe działanie na lampach elektronowych.

Polski lampowy komputer analogowy ARR (Analizator Równań Różniczkowych) 1953 (Autor fot: Marcin Wichary CC–BY 2.0 )

Krótkim etapem pośrednim były komputery cyfrowe, zawierające pojedyncze tranzystory bipolarne oraz układy scalone z tranzystorami bipolarnymi. Prawdziwy rozwój techniki komputerowej nastąpił dopiero wtedy, gdy komputery zaczęto realizować z wykorzystaniem układów scalonych zawierających „prawdziwe tranzystory” MOSFET.

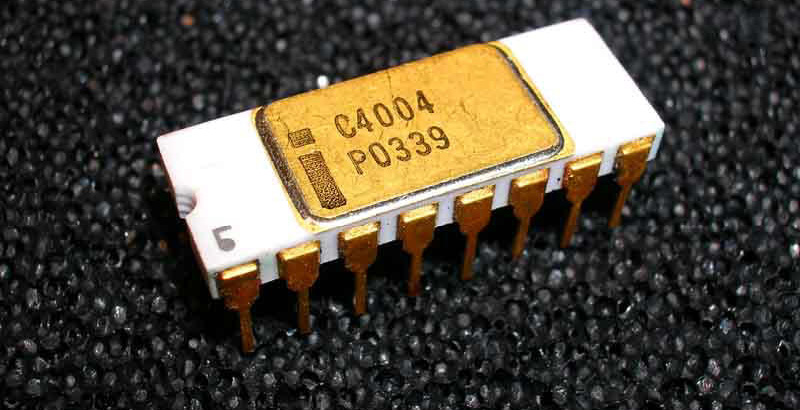

Kamieniem milowym jest rok 1971, kiedy pojawił się pierwszy mikroprocesor Intel 4004 – układ scalony zawierający 2300 tranzystorów MOSFET. Jednak pierwszym naprawdę popularnym był wypuszczony na rynek zaraz potem Intel 8008, następnie 8080. Zgodnie z prawem Moore’a kolejne scalone mikroprocesory zawierały coraz więcej tranzystorów.

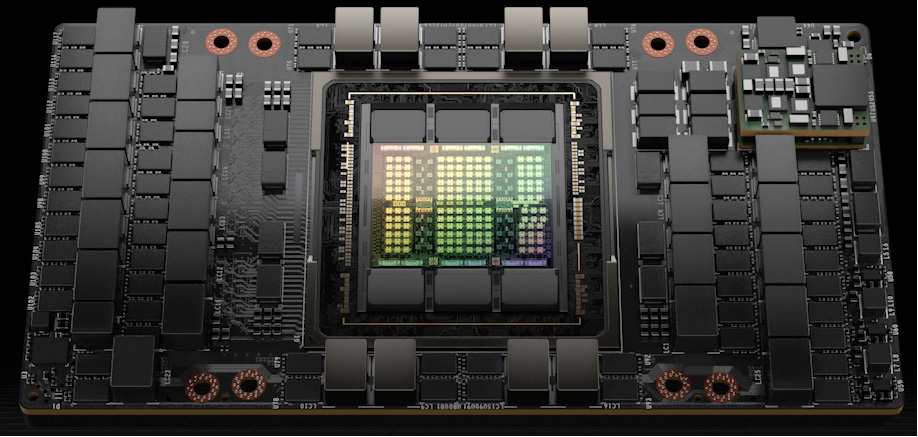

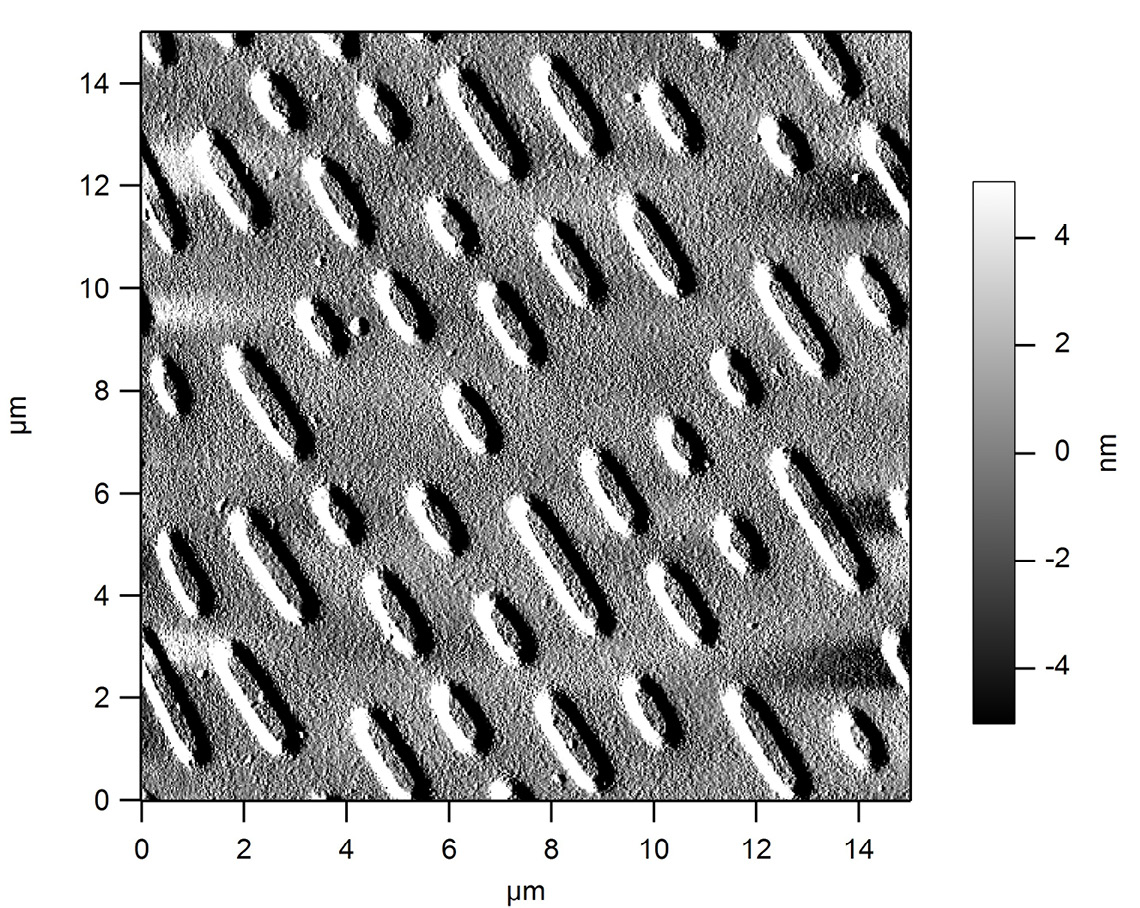

Dziś najnowsze mikroprocesory zawierają w jednej krzemowej płytce kilkadziesiąt miliardów tranzystorów! Tak, kilkadziesiąt miliardów!

Przetwarzanie i transmisja sygnałów

W elektronice podstawowymi zadaniami jest przesyłanie oraz przetwarzanie rozmaitych sygnałów elektrycznych. Na początku robiono to w sposób analogowy Przykładem jest klasyczna radiofonia AM i FM i telewizja analogowa.

Szybko okazało się, że dowolne zadanie – przetwarzanie sygnału (np. wzmacnianie, filtrowanie, zmiana dynamiki) można też zrealizować cyfrowo, czyli za pomocą obliczeń matematycznych. Zamiast bezpośrednio przetwarzać sygnały elektryczne, zamienia się je na postać cyfrową w przetwornikach analogowo-cyfrowych ADC, przetwarza matematycznie za pomocą odpowiedniego programu działającego w mikroprocesorze, a następnie, jeśli trzeba, zamienia się znów na postać analogową za pomocą przetworników cyfrowo-analogowych DAC. I właśnie w dzisiejszych urządzeniach elektronicznych podstawą są mikroprocesory oraz przetworniki ADC i DAC, a do tego rozmaite inne przetworniki i czujniki (sensory).

Także transmisja i przechowywanie (rejestracja) sygnałów w postaci cyfrowej (zer i jedynek) okazała się lepsza od sposobów analogowych, podatnych na szumy, zakłócenia i błędy. Zarówno transmisja przewodowa, jak i bezprzewodowa, z wykorzystaniem fal radiowych, czego przykładem jest telefonia i telewizja cyfrowa oraz sieci Wi-Fi.

Cyfryzacja – digitalizacja i kompresja

Od lat 80. wprowadzano systemy cyfrowej transmisji sygnałów i danych, najpierw w telekomunikacji.

W roku 1982 pojawiła się płyta CD z cyfrowym zapisem sygnałów audio, później płyty DVD i Blu-Ray.

Zasadniczo sygnał elektryczny audio i wideo po digitalizacji, czyli po zamianie na postać cyfrową „zajmuje wiele miejsca”. Kluczową kwestią jest znalezienie efektywnych sposobów kompresji danych cyfrowych, żeby przesyłany czy przechowywany sygnał cyfrowy audio czy wideo „zajmował dużo mniej miejsca”, ale bez znaczącej utraty jakości sygnału. I tu kamieniem milowym jest MP3 – standard kompresji cyfrowego sygnału audio, który opublikowano w roku 1991. Dziś mamy wiele standardów kompresji sygnałów audio i wideo – kodeków i kontenerów (AAC, Vorbis, FLAC, H.264 – MP4. Divx, Xvid, …). Do tego dochodzą inne sposoby i standardy kompresji dowolnych danych cyfrowych (ZIP, RAW) oraz obrazów w postaci cyfrowej (JPG, PNG, GIF, TIFF).

Dawniej urządzenia elektroniczne, np. radioodbiorniki, telewizory, zawierały dedykowane układy i obwody, pełniące określone zadania – funkcje. Dziś te funkcje realizowane są cyfrowo, jako obliczenia matematyczne za pomocą mikroprocesora, czyli w sumie komputera o dużej wydajności obliczeniowej. A dzisiejsze urządzenia elektroniczne, takie jak smartfony, telewizory, dekodery i odtwarzacze są w sumie komputerami.

Sercem większości współczesnych urządzeń elektronicznych jest mniej lub bardziej „silny” mikroprocesor, który współpracuje z przetwornikami ADC, DAC oraz z różnymi innymi przetwornikami i sensorami. ©

Piotr Górecki

Na życzenie Czytelników dowolne z opisanych zagadnień mogą być omówione dokładniej.