Elektronika (nie tylko) dla informatyków (1) Elementy i układy elektroniczne wokół mikroprocesora

Mikroprocesory są dziś powszechnie stosowane w najróżniejszych urządzeniach, nie tylko fabrycznych. Niska cena, łatwość programowania i dostępność wszelkich niezbędnych narzędzi powoduje, że coraz młodsi realizują interesujące układy na bazie mikroprocesorów.

Zdarza się jednak, że twórcy takich konstrukcji, zafascynowani łatwością programowania, popełniają błędy układowe, wynikające z nieznajomości podstaw elektroniki. Okazują się dobrymi informatykami, ale słabymi elektronikami. Niniejszy cykl przedstawiający niezbędne zasady, kluczowe elementy elektroniczne i rozwiązania układowe, opracowany został wprawdzie głównie dla miłośników mikroprocesorów, ale pożytek zeń odniosą wszyscy Czytelnicy.

Mikroprocesor jest dziś najbardziej uniwersalnym układem scalonym. Ogromny zakres zastosowań wynika z faktu, iż wiele mikroprocesorów ma wbudowane rozmaite peryferia, w tym przetworniki analogowo-cyfrowe i cyfrowo-analogowe. Mikroprocesory zazwyczaj współpracują z prostszymi albo bardziej złożonymi czujnikami, elementami wykonawczymi i innymi. Często są to elementy i układy analogowe, a nie cyfrowe. Praktyka pokazuje, że wszelkie układy analogowe przysparzają kłopotów. Brak wiedzy o podstawach elektroniki skutkuje elementarnymi błędami. Ale podstawowa wiedza elektroniczna to za mało, gdy mikroprocesory mają pracować w bardziej złożonych i precyzyjnych układach, zwłaszcza w urządzeniach pomiarowych. Wtedy koniecznie trzeba uwzględnić inne, subtelniejsze właściwości elementów i układów. Nie wystarczy tu umiejętność programowania. Nieznajomość elektroniki przekreśla szansę na prawidłowe i pełne wykorzystanie mikroprocesorów oraz współpracujących z nimi elementów i układów.

Niniejszy artykuł jest pierwszą częścią nowego cyklu, przeznaczonego głównie dla młodych miłośników mikroprocesorów. W ramach cyklu przystępnie podane zostaną zarówno podstawowe prawa elektroniki, jak też praktyczne wiadomości o popularnych elementach i układach. Zasygnalizowane też zostaną istotne problemy, z jakimi spotyka się współczesny elektronik, konstruujący precyzyjne układy i urządzenia.

W pierwszym odcinku podane są informacje o podstawach: prądzie i napięciu, a co bardzo ważne, także o mocy, energii i problemie ciepła. Nawet jeśli uważasz, że znasz te podstawy – przeczytaj artykuł do końca. Większości Czytelników materiał ten pomoże uporządkować i wzbogacić wiedzę o fundamentalnych zagadnieniach elektroniki.

Informatyka a elektronika

Informatyka to przetwarzanie informacji, a informacja to coś z natury ulotnego. W informatyce podstawowe znaczenie mają liczby. Liczby te niosą różne treści i mają różne znaczenie. Informatyka ma więc bardzo ścisły związek z matematyką. Informacja i informatyka same w sobie nie mają żadnego związku z elektrycznością, z napięciem czy prądem. Od wieków wykorzystuje się najrozmaitsze nośniki informacji. I tak nośnikiem informacji były kiedyś nacięcia na kiju, wykonywane przez karbowego, który zaznaczał w ten sposób, ile wozów siana zjechało danego dnia do majątku. Dziś informacje najczęściej zapisujemy na nośnikach magnetycznych i optycznych. Fizycznie rzecz biorąc niematerialna informacja jest reprezentowana przez kierunek namagnesowania materiału ferromagnetycznego albo przez różne właściwości optyczne warstewki metalu czy specjalnego barwnika.

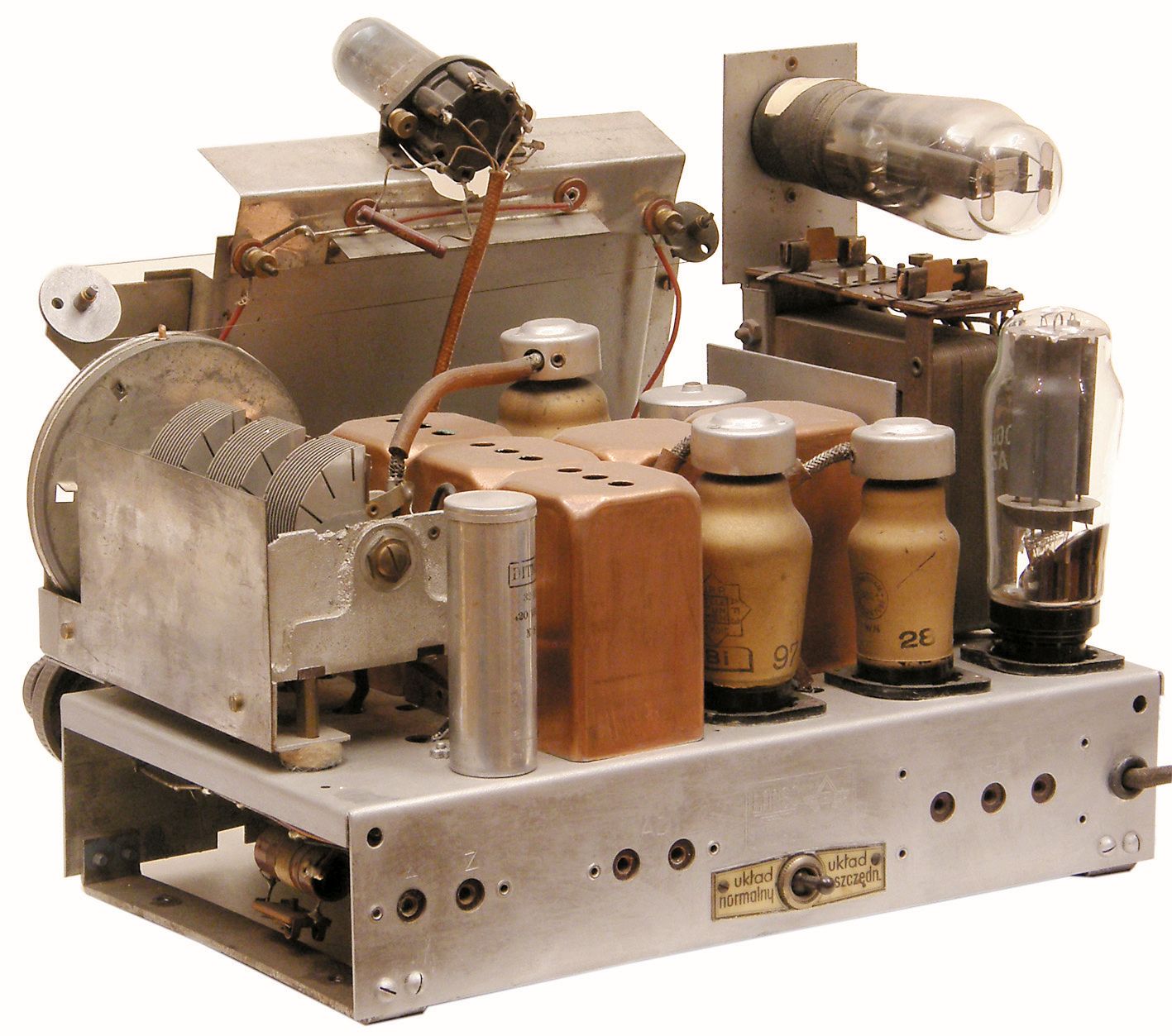

W informatyce trzeba nie tylko przechowywać, zapisywać i odczytywać informacje, ale też informacje przetwarzać. I znów: sama idea przetwarzania informacji nie jest związana z elektrycznością. Na fotografii 1 pokazany jest kalkulator elektromechaniczny, gdzie silnik elektryczny to jedynie źródło napędu, natomiast obliczenia przeprowadzane są za pomocą systemu mechanicznego. Warto pamiętać, że pierwsze komputery elektroniczne opierały się na lampach elektronowych. Starsi Czytelnicy może przypomną sobie, że przed wielu laty w Młodym Techniku opisywany był prosty kalkulator mechaniczny ze spadającymi kulkami, przeprowadzający elementarne operacje na liczbach dwójkowych, a inni zapewne pamiętają archaiczne maszyny liczące – stare mechaniczne albo elektromechaniczne kasy sklepowe.

Jak najbardziej możliwa jest więc realizacja elektromechanicznych (przekaźnikowych), ale także parowych, pneumatycznych czy hydraulicznych systemów przetwarzania informacji. Jest to wprawdzie możliwe, ale zbyt skomplikowane i kosztowne – nie ma żadnego uzasadnienia ekonomicznego. Dziś informacje przetwarza się na drodze elektronicznej z wykorzystaniem elementów półprzewodnikowych – tranzystorów. Także do przechowywania informacji, oprócz klasycznych nośników magnetycznych i optycznych, coraz częściej wykorzystuje się pamięci FLASH, zbudowane z tranzystorów. I tu doszliśmy do ważnego zagadnienia praktycznego: otóż koniecznie musisz rozumieć, że choć celem jest przetwarzanie informacji, a więc czegoś niematerialnego i ulotnego, jednak nie umiemy tego robić „na abstrakcjach”. Zawsze musimy wykorzystać „dotykalną” reprezentację. Ideał to przetwarzanie informacji bez zużywania energii. Tego nie umiemy, a jak na razie, potrafimy to zrobić w miarę szybko i tanio właśnie z wykorzystaniem reprezentacji elektrycznej. Przy okazji należy wyraźnie podkreślić, że dwójkowy system zapisu liczb, powszechnie stosowany w informatyce, też sam w sobie nie jest związany z elektroniką. Przed laty podejmowane były próby przetwarzania informacji zapisanej jako liczby w systemie dziesiętnym , np. w starych kalkulatorach (elektro)mechanicznych, kasach oraz pierwszych kalkulatorach elektronicznych. Jednak szybko okazało się, że najwygodniejszy do przetwarzania i przechowywania informacji jest system dwójkowy.

Zapewne wiesz, że analogicznie jak w systemie dziesiętnym mamy dziesięć cyfr (od zera do 9), tak w systemie dwójkowym mamy tylko dwie cyfry: 0 i 1. Cyfry (oraz liczby) to wprawdzie pojęcia czysto abstrakcyjne, jednak sytuacja tak się ukształtowała, że przy przetwarzaniu w mikroprocesorach, zgodnie z intuicją, cyfrę 0 reprezentuje brak napięcia czyli napięcie równe zeru, a cyfrę 1 – obecność napięcia (zazwyczaj w zakresie 3…5 V). Przy przechowywaniu danych na nośnikach magnetycznych i płytach optycznych sprawa jest znacznie bardziej złożona, jednak dla praktyka- elektronika nie ma to żadnego znaczenia, ponieważ „nie dotyka” on bezpośrednio zapisu na nośniku (płycie, dyskietce, dysku twardym), tylko wysyła i odbiera dane w postaci „elektronicznych” zer i jedynek czyli przebiegów napięcia i prądu.

Każdy, kto chce wykorzystywać mikroprocesory powinien dobrze rozumieć, że tak naprawdę nie są to jakieś idealne zera i jedynki, tylko nieidealne przebiegi napięcia i związane z tym prądy. A napięcie i prąd nierozłącznie związane są z mocą. Z kolei moc jest ściśle związana z ciepłem i wzrostem temperatury. Tematem niedoskonałości i zakłóceń „zer i jedynek” zajmiemy się później, a na razie musimy bliżej przyjrzeć się bardzo ważnej kwestii napięcia, prądu, energii i mocy.

Napięcie i prąd

Wiesz ze szkoły, że nośnikami prądu elektrycznego są elektrony (a także jony i tzw. dziury). Powinieneś pamiętać, że ruch takich nośników jest ściśle związany z energią i różnicami energii. Prąd elektryczny to ruch nośników, zazwyczaj elektronów, ale też dziur lub jonów. Występujące tu zależności można dobrze zilustrować analogią wodną. Chyba jest dla Ciebie oczywiste, że odpowiednikiem prądu elektrycznego jest przepływ wody. Możesz sobie wyobrażać, że przepływ kropel wody odpowiada przepływowi elektronów. Prąd na schematach i wzorach oznaczamy z reguły literą I. Natężenie prądu elektrycznego wyrażamy w amperach (także w miliamperach, mikroamperach, nanoamperach, a nawet pikoamperach). Dla ciekawości podam, że nazwa jednostki, amper, pochodzi od nazwiska francuskiego fizyka André Marie Ampere. Przepływ prądu o natężeniu jednego ampera (I = 1 A) oznacza przepłyniecie 6241506363094027800, czyli ponad sześciu trylionów elektronów na sekundę. Nie zawracaj sobie jednak głowy tymi cyferkami.

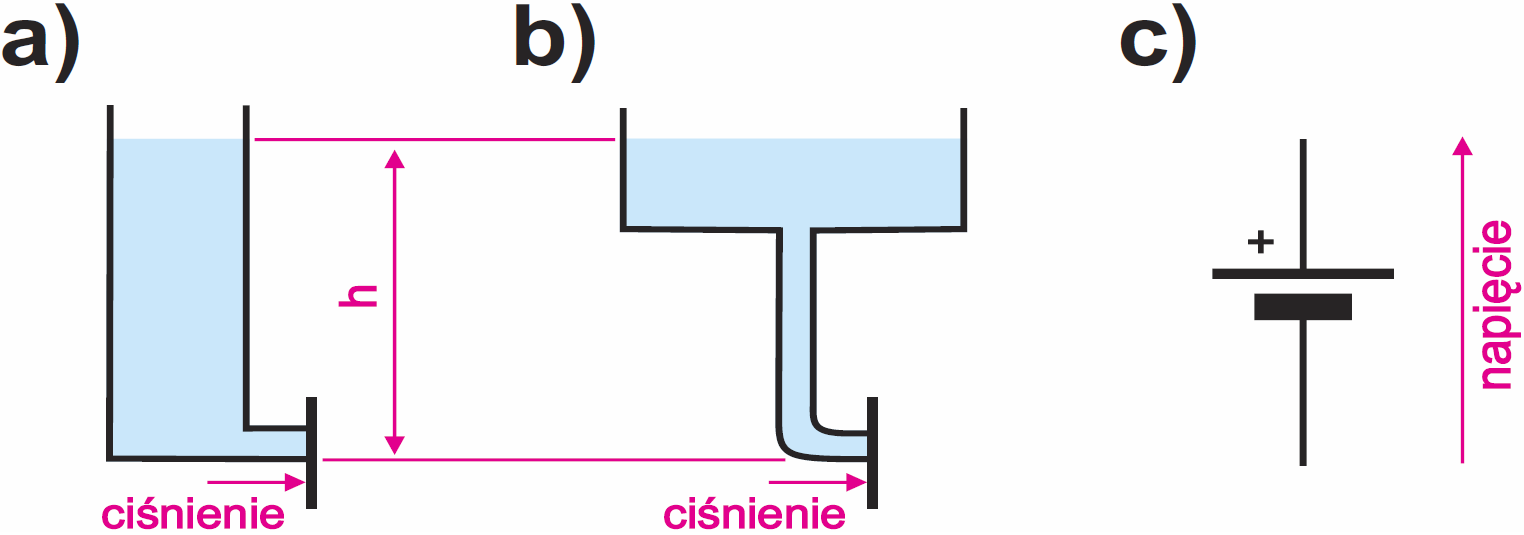

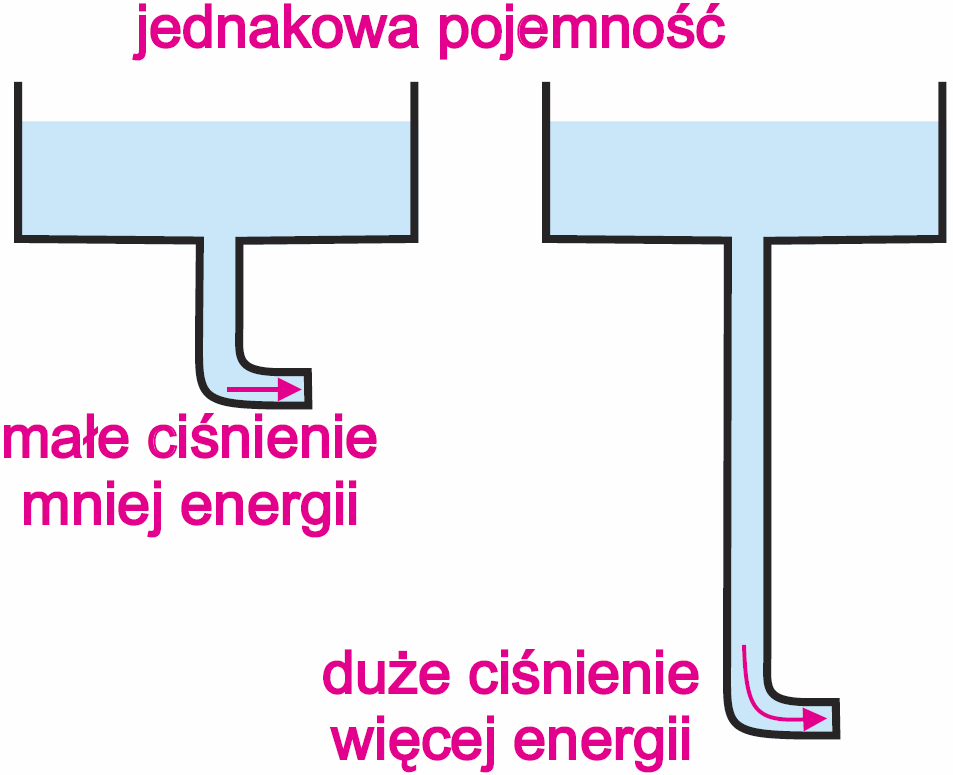

Nie masz chyba wątpliwości, że w analogii wodnej odpowiednikiem baterii czy akumulatora może być zbiornik wodny. Najprościej biorąc, odpowiednikiem napięcia elektrycznego jest ciśnienie wody. W uproszczeniu można powiedzieć, że ciśnienie wody związane jest z różnicą poziomów wody (wysokością słupa wody – h). Podobnie jest z napięciem elektrycznym. Ze szkoły prawdopodobnie pamiętasz, że napięcie elektryczne to inaczej różnica potencjałów. Ilustruje to rysunek 2. Warto dodać, że lepszym odpowiednikiem baterii/akumulatora jest zbiornik z rysunku 2b. W zbiorniku według rysunku 2a ciśnienie wyjściowe (napięcie) wraz z upływem wody jednostajnie zmniejsza się od wartości maksymalnej do zera. Bateria się tak nie zachowuje (raczej naładowany kondensator). Bateria zachowuje się podobnie jak system z rysunku 2b, w którym ciśnienie (napięcie) przez większość czasu pracy zmniejsza się niewiele. Rysunek 2c pokazuje stosowany na schematach symbol baterii, akumulatora – ogólnie symbol źródła napięcia stałego. O ile ciśnienie można podawać w różnych jednostkach, np. hektopaskalach, barach, milimetrach słupa rtęci, czy nawet milimetrach słupa wody, o tyle napięcie elektryczne zawsze podaje się w woltach (ewentualne w kilowoltach, miliwoltach czy mikrowoltach). Nazwa jednostki wolt, w skrócie V, to uhonorowanie włoskiego fizyka, który nazywał się Alessandro Volta. Do pomiaru napięcia, czyli różnicy potencjałów, służy woltomierz. Zgodnie z rozpatrywaną analogią, odpowiednikiem woltomierza jest miernik ciśnienia wody.

Na schematach i w opisach napięcie zazwyczaj oznacza się literą U, w zagranicznych źródłach także literą V. Zapis U=1,2 V czytamy: napięcie wynosi jeden i dwie dziesiąte wolta. Zapis U=16 mV czytamy: napięcie równe 16 miliwoltów. Natomiast U=50 uV oraz U=50 μV oznacza napięcie wynoszące 50 mikrowoltów. Zamiast małej greckiej litery mi (μ) oznaczającej mikro, czyli jedną milionową, warto używać podobnej nieco zwykłej literki u. Problem w tym że często w druku czy na ekranie komputera greckie mi (μ) zamienia się w małą literkę m, która oznacza mili, czyli jedną tysięczną. Dlatego greckie mi (μ) bezpieczniej jest zastępować małą literką u.

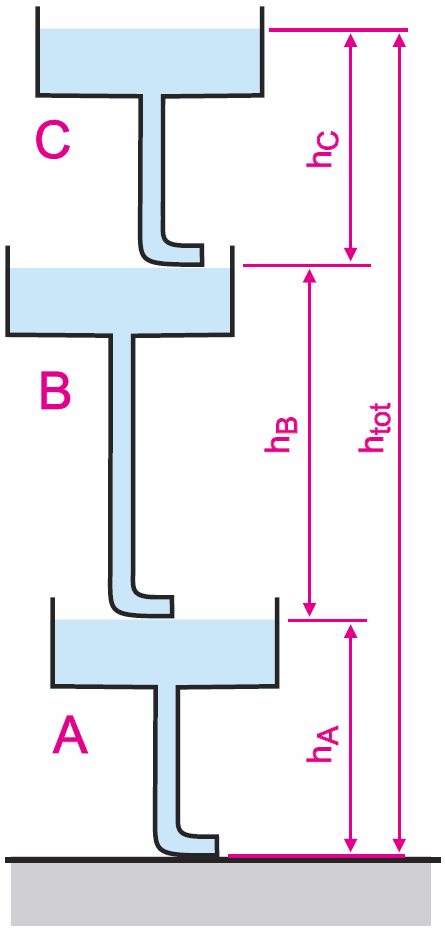

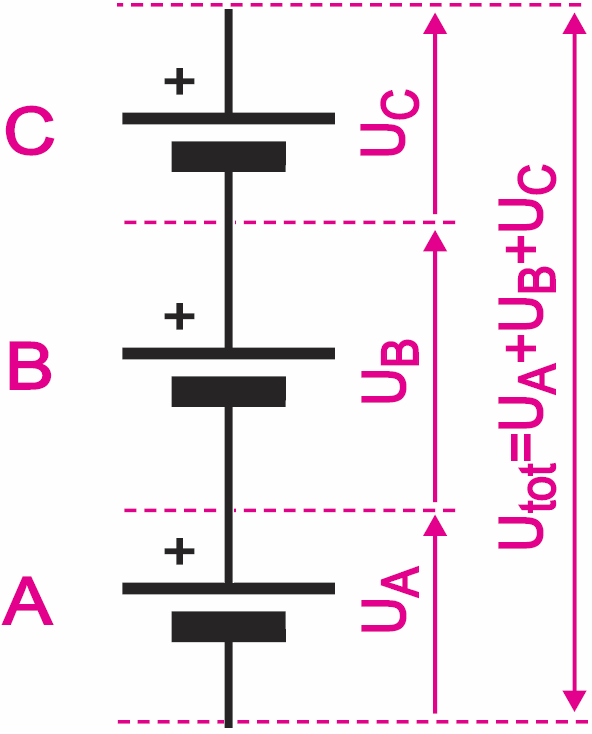

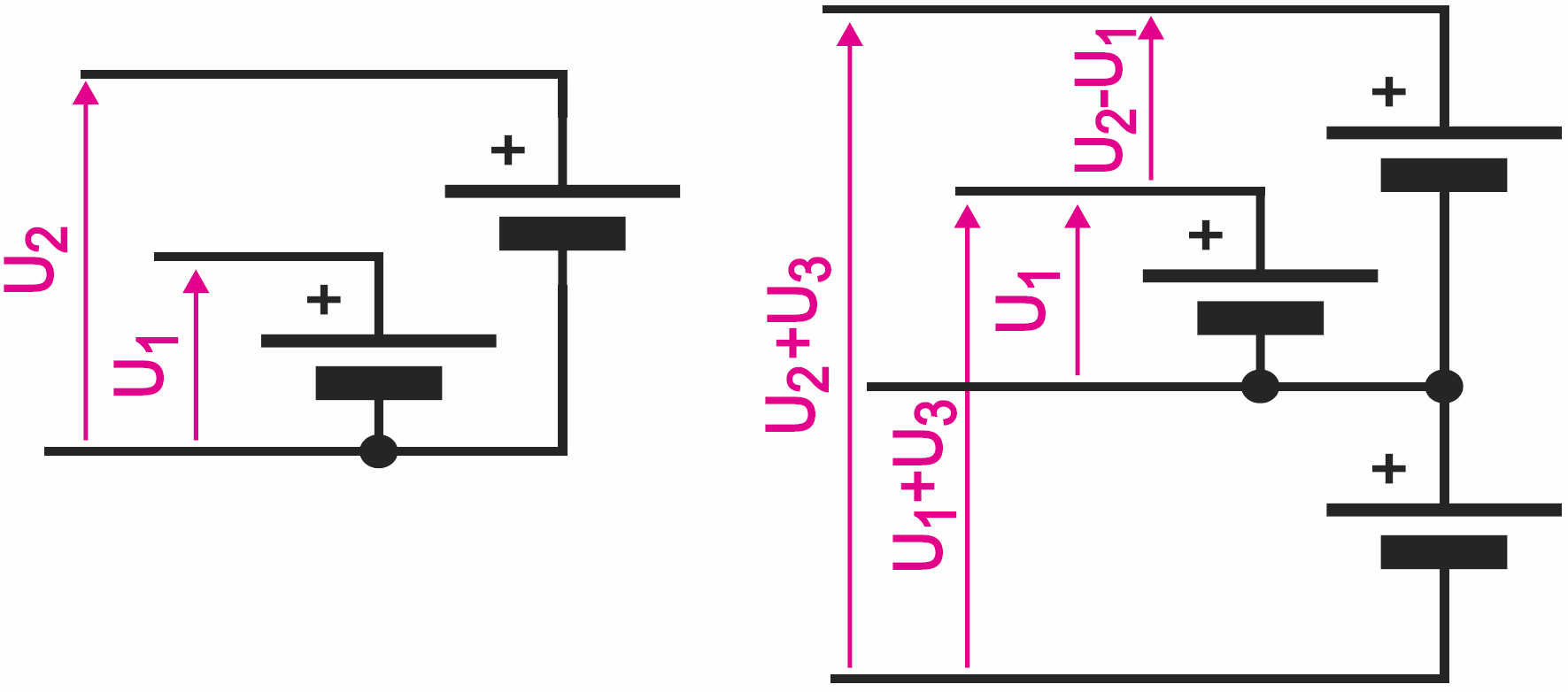

A teraz popatrz na rysunek 3. W systemie hydraulicznym oznaczonym A ciśnienie wody jest takie same, jak w systemie C, bo różnice poziomów oznaczone hA i hC są jednakowe. Chyba też jest dla Ciebie jasne, że ciśnienie całkowite pomiędzy poziomami górnym i dolnym, jest sumą ciśnień trzech systemów A, B, C i jest wyznaczone wysokością słupa wody od poziomu htot. Dokładnie tak jest też w układzie elektrycznym, jak pokazuje rysunek 4. W praktyce bardzo często kilka źródeł napięcia współpracuje ze sobą.

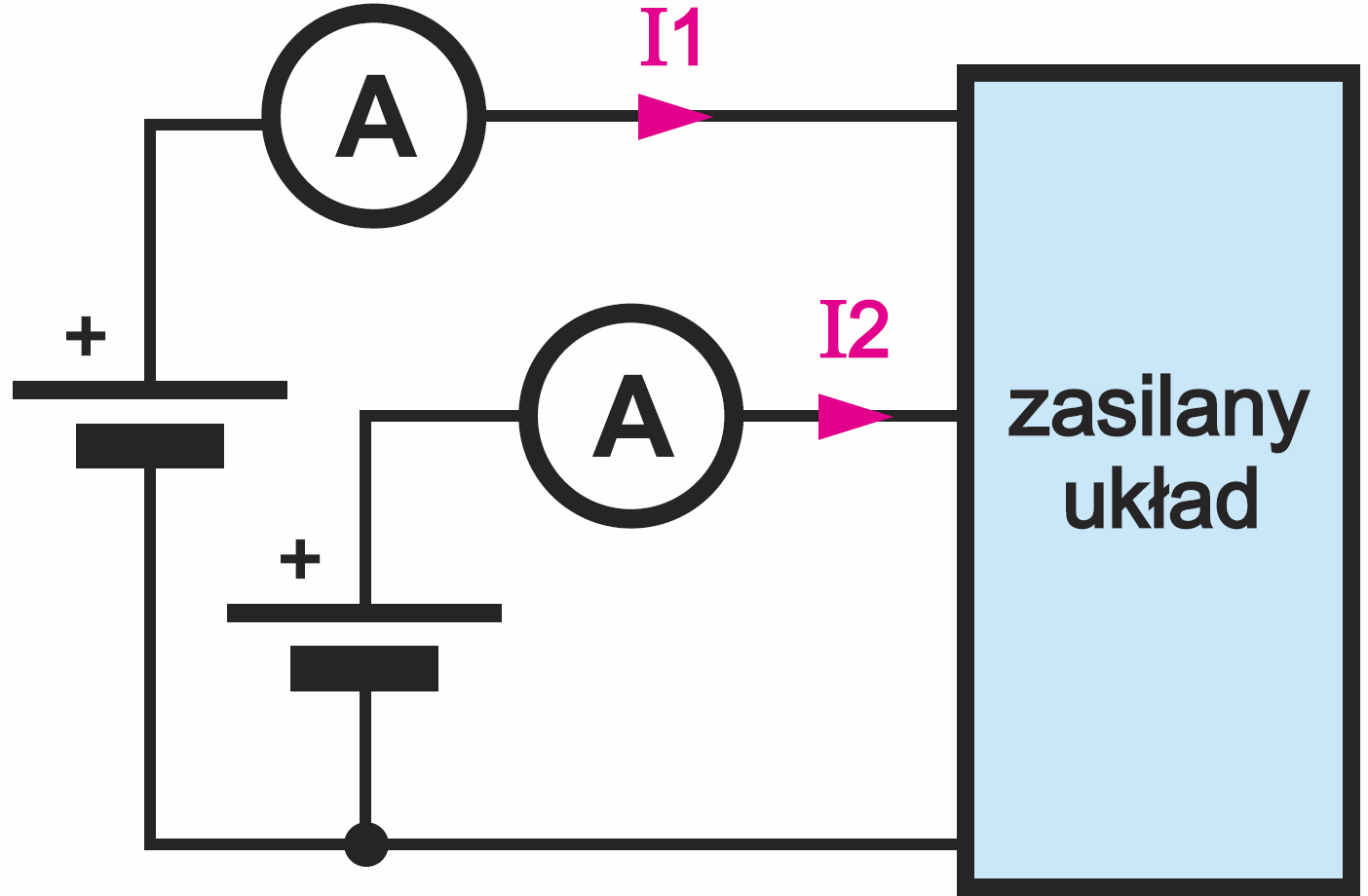

Dwa dość często spotykane przypadki pokazane są na rysunku 5.

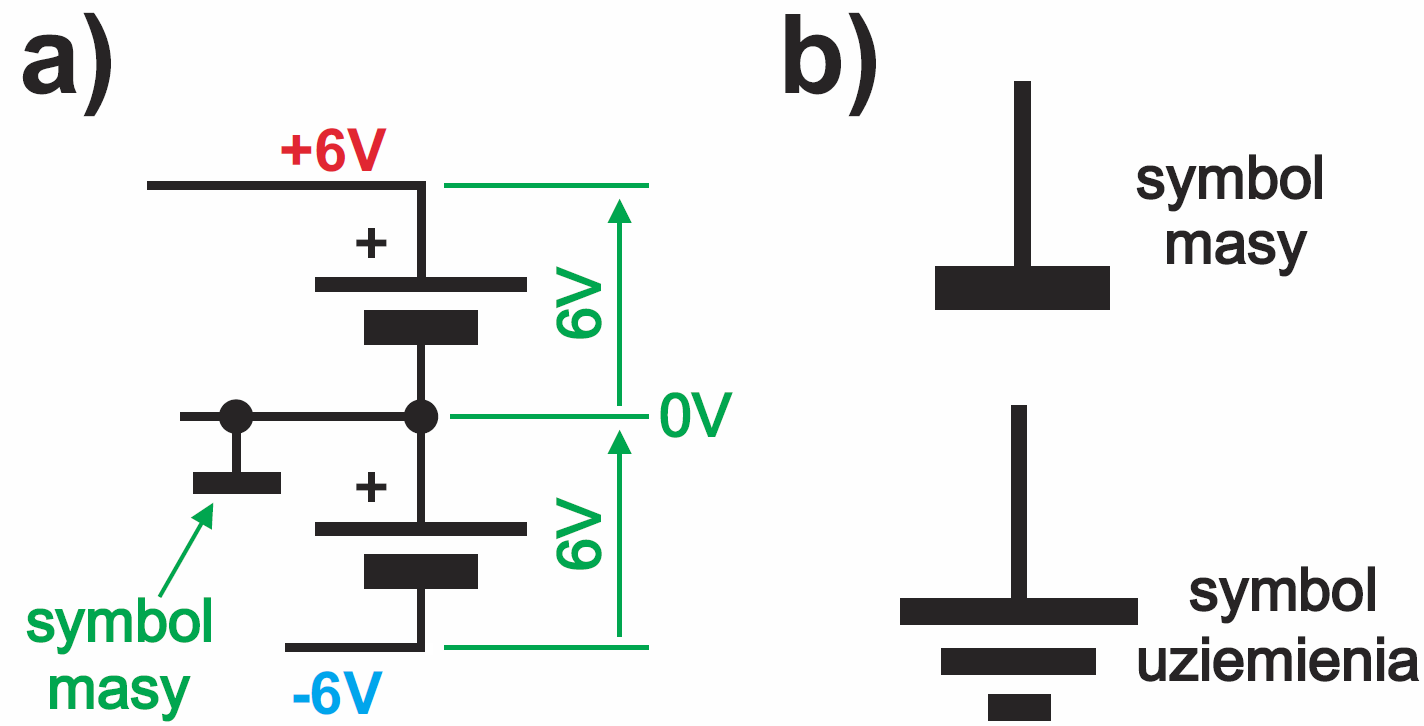

Trzy ostatnie rysunki budzą pytanie o ważny szczegół: pytanie o poziom zerowy. Nie o zerowe ciśnienie, tylko o poziom zerowy, a w przypadku napięcia, które jest różnicą potencjałów – o zerowy potencjał. Chyba wiesz, że często, ale nie zawsze, za zerowy poziom wody przyjmuje się poziom morza. Dokładnie tak samo jest z potencjałem elektrycznym i napięciami: czasem za zerowy potencjał przyjmuje się potencjał elektryczny Ziemi. I wtedy mówi się o uziemieniu. W praktyce uziemianie, czyli dołączanie jakiegoś punktu układu do ziemi nie wynika z dążenia do pracy na „bezwzględnym poziomie zerowym”. Uziemienie stosuje się w obwodach sieci energetycznej głównie ze względów bezpieczeństwa, a w innych układach zazwyczaj z uwagi na zmniejszenie zakłóceń lub zwiększenie czułości anten – ale to oddzielne, szerokie tematy.

Choć więc można mówić o „prawdziwie zerowym” potencjale elektrycznym ziemi, w praktyce jako poziom zerowy można przyjąć… dowolny potencjał i mierzyć napięcia względem niego. I tak się zwykle robi. Zupełnie nie zwracając uwagi na potencjał ziemi, w układach przyjmujemy jakiś punkt (obwód) i przyjmujemy, że ma on potencjał zerowy – potencjał odniesienia. Przed laty urządzenia elektroniczne realizowane były z wykorzystaniem lamp elektronowych i montowano je na masywnych, sztywnych podstawach wykonanych z blachy. Fotografia 6 pokazuje odbiornik radiowy Largo z roku 1937 montowany w wileńskich zakładach Elektrit. Ta masywna blaszana podstawa, zwana chassis (czytaj szasi) dołączana była do ujemnego bieguna głównego napięcia zasilania (tzw. napięcia anodowego).

Kontrolując napięcia w układzie, mierzono większość z nich względem masy, czyli tej metalowej podstawy. Dziś półprzewodnikowe urządzenia zupełnie nie przypominają układów lampowych, ale do dziś pozostało pojęcie masy jako obwodu odniesienia i potencjału zerowego. Choć teoretycznie obwód masy mógłby być dowolnym spośród obwodów w układzie, jednak w zdecydowanej większości układów zasilanych pojedynczym napięciem, jako masę, czyli zerowy obwód odniesienia traktuje się ujemny biegun zasilania. I nieprzypadkowo ścieżki i przewody tego obwodu są grubsze, niż innych obwodów, ale to oddzielny temat, do którego jeszcze wrócimy. Gdy występuje kilka źródeł zasilania, masą nie zawsze jest najbardziej ujemny obwód zasilania. I wtedy mówimy o napięciach ujemnych (względem masy), jak pokazuje prosty przykład z rysunku 7a. Ten „zerowy” obwód masy wyróżniamy na schematach specjalnym symbolem masy. Często oznaczany jest on też skrótem GND (od angielskiego Ground). Warto wiedzieć, że istnieje pokrewny symbol – rysunek 7b, wskazujący na uziemienie, czyli prawdziwe dołączenie do ziemi (ściślej do zakopanego w ziemi przedmiotu, np. metalowej rury wodociągowej), ale obecnie, zwłaszcza przy korzystaniu z komputerowych programów do rysowania schematów, symbol ten bywa niekonsekwentnie używany jako symbol masy, a nie uziemienia. Ale wracajmy do głównego wątku.

Energia i moc

Analogia hydrauliczna pomaga zrozumieć pojęcia prądu i napięcia elektrycznego. Warto jednak od początku rozumieć jeszcze dwa kluczowe pojęcia: energię i moc.

Ogólnie biorąc, energia to zdolność do wykonania pracy lub wykonana praca. Natomiast moc to ilość pracy wykonana w jednostce czasu.

Wróćmy do analogii wodnej. To oczywiste, że jeśli woda spływa z górnego zbiornika do dolnego, to wykonuje pracę. Niech przykładem będzie młyn wodny: woda z górnego zbiornika oddaje energię, a ściślej biorąc, następuje tu zamiana energii potencjalnej wody na energię mechaniczną. Natomiast żeby wodę przenieść (przepompować) ze zbiornika dolnego do górnego, trzeba wykonać pracę – praca mechaniczna zostaje zamieniona na energię potencjalną. Ta wykonana praca, inaczej mówiąc – zużyta energia, nie ginie, tylko następuje przekazanie i zmiana formy energii.

W tym kontekście interesującym przykładem i analogią jest elektrownia szczytowo-pompowa przedstawiona na fotografii 8 – elektrownia Żydowo. Taka elektrownia ilustruje działanie akumulatora, w którym następuje zamiana energii chemicznej (wiązań chemicznych) na energię elektryczną i na odwrót. Wieczorem, gdy jest największe zapotrzebowanie na energię elektryczną, woda z górnego zbiornika elektrowni spada do dolnego, porusza turbiny wytwarzające prąd. To faza rozładowania.

Woda traci energię potencjalną, która zamienia się na energię elektryczną. W ciągu dnia odwrotnie: poruszane silnikami elektrycznymi pompy transportują wodę z dolnego zbiornika do górnego. To faza ładowania: energia elektryczna zamieniana jest z powrotem na energię potencjalną wody.

Ogólnie biorąc, podobnie jest z nośnikami ładunku elektrycznego (elektronami). Można powiedzieć, że wyższy potencjał oznacza większą energię. Elektron „spadając” oddaje część swojej energii. Na razie nie próbuj szczegółowo dociekać skąd, czy dokąd spada elektron – to nie jest konieczne (niemniej z takim wyobrażeniem masz/będziesz mieć do czynienia np. przy opisie działania diody LED: elektrony w siatce krystalicznej półprzewodnika spadając na niższe powłoki elektronowe oddają część swej energii w postaci kwantów światła). Na razie zapamiętaj tylko, że napięcie elektryczne ma realny związek z energią.

To naprawdę ważna sprawa, ponieważ wielu elektroników traktuje napięcie i prąd elektryczny jako pojęcia „czysto elektryczne”, nie mające związku z innymi działami fizyki. Dotyczy to zwłaszcza napięcia elektrycznego, które zupełnie nie jest kojarzone z pracą czy energią. Tymczasem napięcie elektryczne nie tylko ma związek z pracą, ale wręcz jest pracą. Można powiedzieć, że napięcie elektryczne to praca związana z przeniesieniem elementarnego ładunku elektrycznego (elektronu) z punktu o jednym potencjale do punktu o innym potencjale elektrycznym.

Natomiast prąd (natężenie prądu) to łatwe do intuicyjnego zaakceptowania natężenie przepływu tych elementarnych ładunków elektrycznych (ilość przepływających ładunków w jednostce czasu).

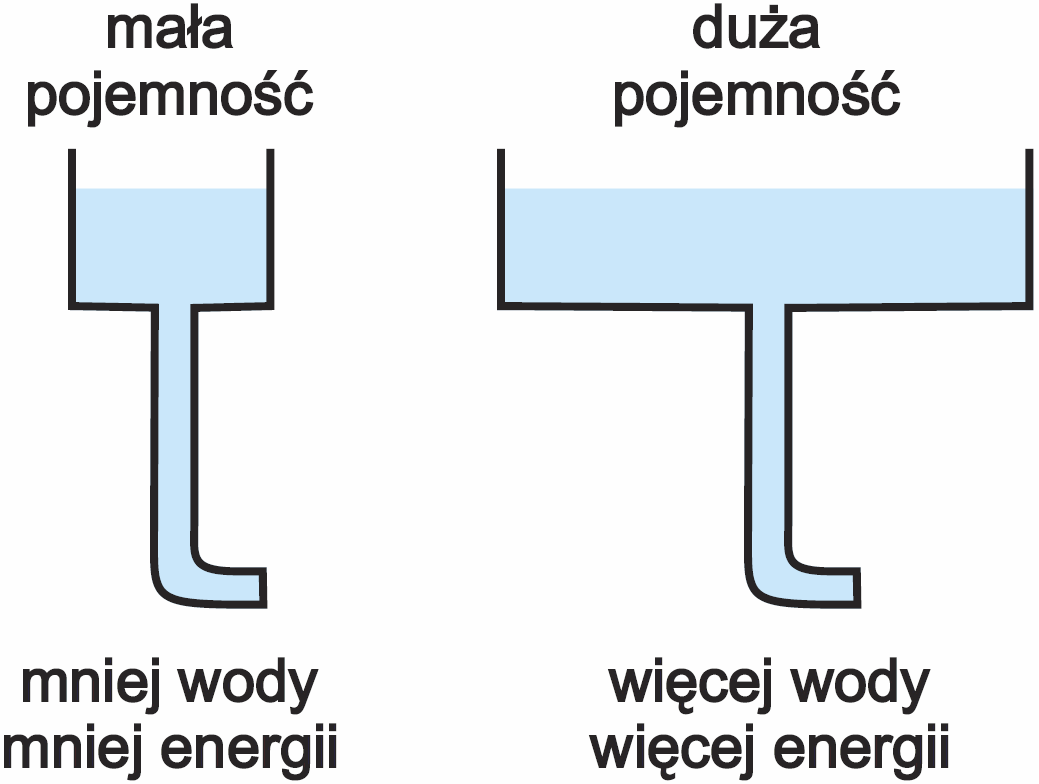

Pojemność

Chyba czujesz intuicyjnie, że w analogii hydraulicznej czym większa jest pojemność zbiornika, tym więcej energii jest w nim zgromadzonej. Podobnie w baterii i akumulatorze mówimy o pojemności, czyli ilości zgromadzonych tam nośników prądu. Ilustruje to rysunek 9. I to jest chyba oczywiste, prawda?

Pojemność baterii to inaczej ilość zgromadzonego w niej ładunku. Chodzi o parametr znany z lekcji fizyki – ładunek wskazuje po prostu na liczbę zgromadzonych nośników (elektronów). We wzorach w podręcznikach fizyki ładunek oznaczany jest często literą Q i wyrażany w kulombach (od nazwiska francuskiego fizyka Charlesa Coulomba). Ładunek jednego kulomba ma 6241506363094027800, czyli ponad sześć trylionów elektronów. Wszystko jasne!

Doskonale czujemy, czym jest ładunek Q… Okazuje się jednak, że w elektronice fundamentalnym i bardzo często używanym parametrem nie jest ładunek Q. W elektronice najczęściej używanym podstawowym pojęciem jest prąd I (ściślej natężenie prądu). I tu ważny szczegół, o którym trzeba wiedzieć: prąd to inaczej zmiana ładunku w czasie, lub jeszcze inaczej: prąd to szybkość zmian ilości ładunku (dla wtajemniczonych I = dq / dt, w uproszczeniu I = Q/t, stąd Q = I×t). Co równie ważne Q = I×t, więc 1 kulomb to inaczej 1 amperosekunda: 1 C = 1 A × 1 s = 1 As

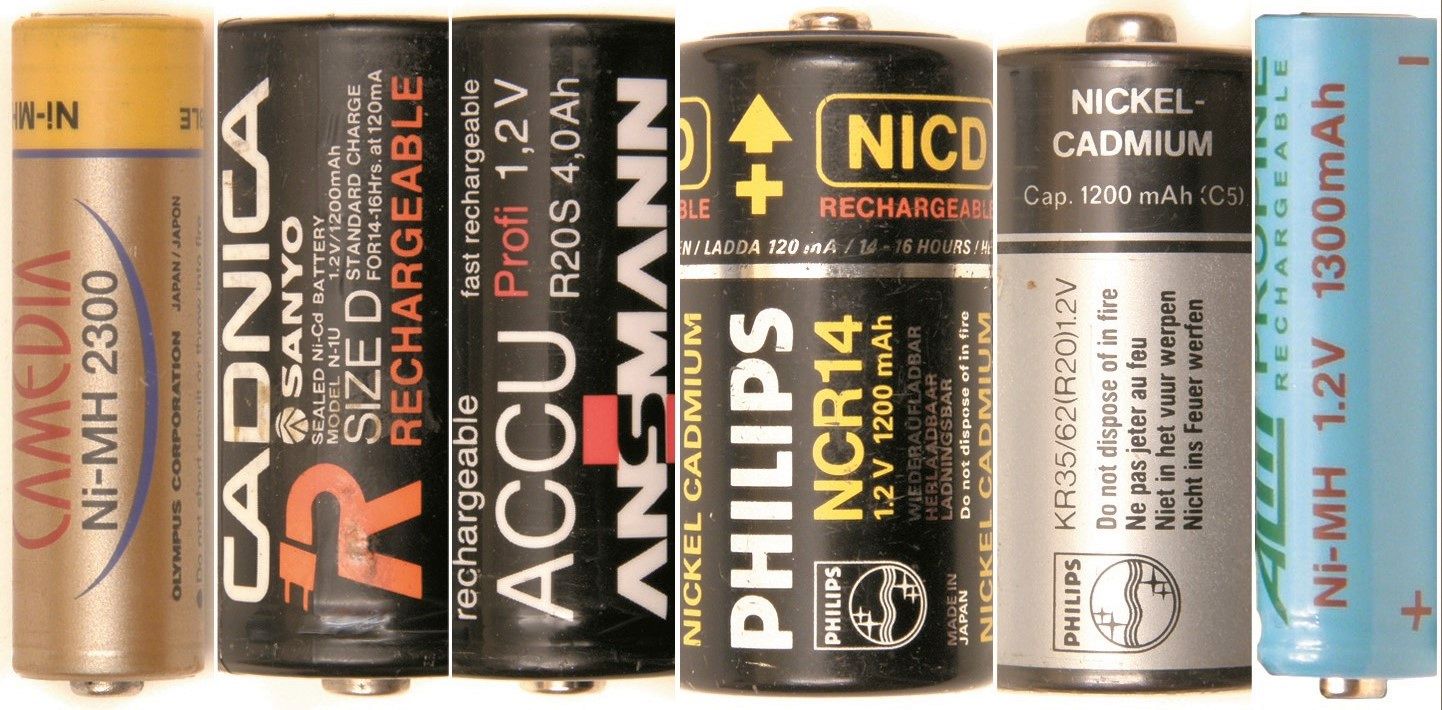

Możemy powiedzieć, że jeden kulomb to ładunek, przeniesiony przez prąd jednego ampera płynący przez jedną sekundę. I to jest jasne, ale szkopuł w tym, że w praktyce pojemności akumulatorów nie wyrażamy w kulombach, czyli w amperosekundach. Pojemność akumulatorów i baterii podaje się w amperogodzinach (Ah) lub miliamperogodzinach (mAh) – patrz przykłady na fotografii 10.

Nie jest to jednak „inna pojemność”. Przecież potrafimy przeliczyć, wiedząc, że godzina ma 3600 sekund. Na przykład przeliczamy amperogodziny na kulomby:

1 Ah = 1 A × 1 h = 3600 As = 3600 C

1 mAh = 1 mA × 3600 s = 3,6 C

A tak na marginesie: łatwo tu o pomyłkę, ponieważ jednostka ładunku, kulomb ma skrót C. Jeśli np. mówimy o ładunku równym 1,8 kulomba, można napisać Q = 1,8 C. Tymczasem w praktyce pojemność baterii i akumulatorów zazwyczaj oznacza się nie literą Q, tylko właśnie literą C. I tak napiszemy na przykład, że jakaś maleńka zegarkowa bateryjka ma pojemność C=10 mAh. Oczywiście moglibyśmy to przeliczyć na kulomby: C = 10 mAh = 36 C, ale pojemności akumulatorów nigdy nie podajemy w kulombach. Dodatkowo już teraz zapamiętaj, że C – pojemność akumulatora (wyrażona w amperogodzinach) to coś innego niż pojemność kondensatora, która też oznaczana jest literą C, ale wyrażana jest w faradach, np. C=0,22 F. Pomimo wspólnej nazwy pojemność, chodzi o zupełnie różne parametry, a farad to coś innego, niż kulomb czy amperogodzina.

Pojemność i energia

W analogii hydraulicznej odpowiednikiem pojemności baterii wyrażonej w amperogodzinach jest pojemność zbiornika wody (wyrażona choćby w litrach). Czy czujesz intuicyjnie, co też sugeruje rysunek 11, że ilość zgromadzonej energii zależy nie tylko od ilości wody (rysunek 9), ale też od różnicy poziomów – od ciśnienia?

Nie zdziwi Cię więc „elektryczny” wzór na energię:

E = U×Q = U×I×t

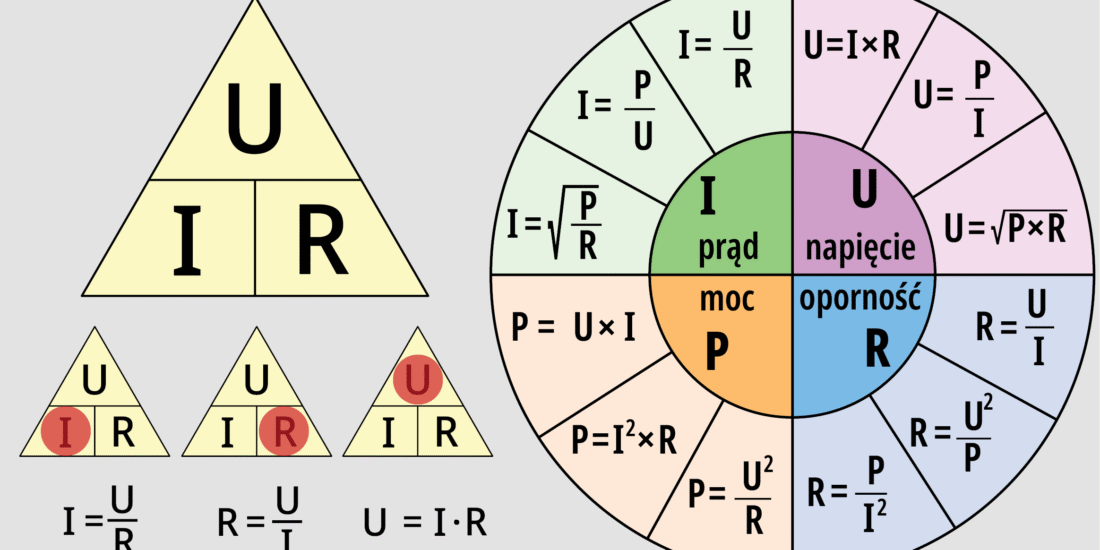

Dopiero ten wzór pozwala obliczyć ilość energii zawartej w danym akumulatorze. Ale nas częściej interesuje nie całkowita ilość, tylko chwilowy pobór energii, inaczej mówiąc – moc. We wzorach zazwyczaj energię oznaczamy literą E lub W, natomiast moc oznacza się literą P od angielskiego Power. Może pamiętasz z fizyki wzory P=E/t i E=P×t oraz określenie, że moc to praca (energia) wykonana/zużyta w jednostce czasu. Jeśli tak, to mamy prosty i elegancki wzór na moc elektryczną:

P = E/t = U×I×t/t P = U×I

Jednostką energii jest dżul, w skrócie J (od nazwiska fizyka angielskiego Jamesa Joule’a). Natomiast jednostką mocy jest wat (od nazwiska konstruktora maszyny parowej Jamesa Watta). Ze szkoły podstawowej być może pamiętasz, że 1 dżul to praca, jaka jest wykonana, gdy siła 1 niutona powoduje przesunięcie o 1 m. 1 J =1 N × 1 m

Ale może wiesz także, że zgodnie ze wzorem E=P×t, dżul to inaczej watosekunda. 1 J = 1 W × 1 s = 1 Ws

1 dżul to energia wydzielona przy mocy 1 wata przez czas 1 sekundy.

W praktyce elektronicznej rzadziej wyrażamy energię nie w dżulach (J), czyli watosekundach, a znacznie częściej spotykamy się z wyrażaniem energii w kilowatogodzinach i watogodzinach.

Zgodnie ze wzorem E=P×t:

1 Wh = 1 W × 1 h =1 W × 3600 s = 3600 Ws = 3600 J

oraz:

1 kWh = 1 kW × 1 h = 1 kW × 3600 s = 1000 W × 3600 s = 3600000 Ws

Dotyczy to nie tylko comiesięcznych rozrachunków z zakładem energetycznym, ale też energii akumulatorów i baterii. Bardzo rzadko podaje się, ilość energii zawartej w akumulatorze czy zestawie akumulatorów. Nie ma żadnego problemu: obliczymy energię mnożąc pojemność (ładunek – Q), wyrażoną w amperogodzinach Ah, przez napięcie tego ogniwa w woltach – wynik wyjdzie w watogodzinach.

E [Wh] = Q [Ah] × U [V]

a przykład:

E = 2,4 Ah × 1,2 V = 2,88 VAh = 2,88 Wh = 10368 Ws = 10368 J = 10,368 kJ

Bateria i zasilacz

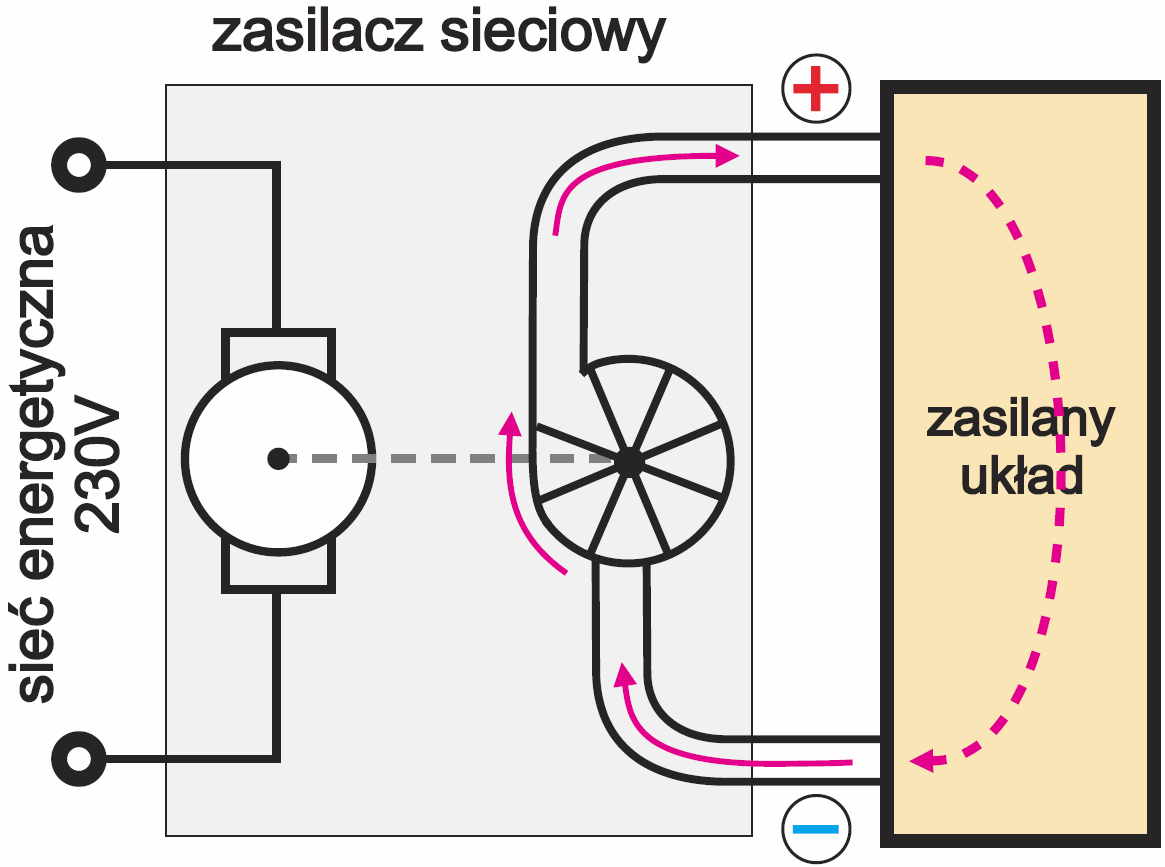

Mówiliśmy, że hydrauliczną analogią baterii czy akumulatora jest zbiornik wodny o określonej pojemności i wysokości słupa wody (rysunek 2b). Taka analogia pomaga zrozumieć pojęcie potencjałów i napięcia elektrycznego, którego odpowiednikiem jest ciśnienie i związana z tym wysokość słupa wody oraz pojęcie pojemności akumulatora/baterii. A co byłoby hydraulicznym odpowiednikiem zasilacza sieciowego?

Tak! Hydraulicznym odpowiednikiem zasilacza sieciowego jest pompa, jak ilustruje to rysunek 12. W przypadku akumulatora czy baterii mówiliśmy o ich pojemności. W przypadku zasilacza sieciowego, który podłączony do sieci energetycznej może pracować nieustannie, pojęcie pojemności nie ma sensu. Ale analogia z pompą wskazuje, że w przypadku zasilacza mają sens dwa podstawowe pojęcia:

– napięcie wyjściowe (ciśnienie wytwarzane przez pompę)

– maksymalny prąd wyjściowy (wydajność pompowania wody).

Ponieważ zasilacz podłączony do sieci 230 V może w sposób ciągły oddawać energię, nie ma sensu mówić o ilości energii, jaką dysponuje zasilacz (jest ona teoretycznie nieskończona). Jest natomiast sens mówić o mocy, jaką oddaje, czy też może oddawać zasilacz: P = U×I

Analogia z pompą ułatwia zrozumienie jeszcze jednego podstawowego i bardzo ważnego faktu. Mianowicie: prąd elektryczny zawsze płynie w zamkniętych obwodach. Wcześniejsza uproszczona analogia ze zbiornikiem wodnym tego faktu nie ilustruje. Do tych spraw jeszcze powrócimy.

Na rysunku 12 są też znaki plus i minus oraz kierunek obiegu wody. Zgodnie z intuicją plus wskazuje na wyższe ciśnienie, minus na niższe, a strzałki – kierunek pompowania wody. W przypadku wody sprawa jest oczywista. Może jednak słyszałeś, że zaznaczany na schematach elektrycznych kierunek prądu jest przeciwny, niż rzeczywisty kierunek ruchu elektronów. To prawda, ale zupełnie nie zajmuj sobie tym głowy. W elektronice przyjmujemy, że w zewnętrznych obwodach prąd płynie od plusa do minusa źródła zasilania.

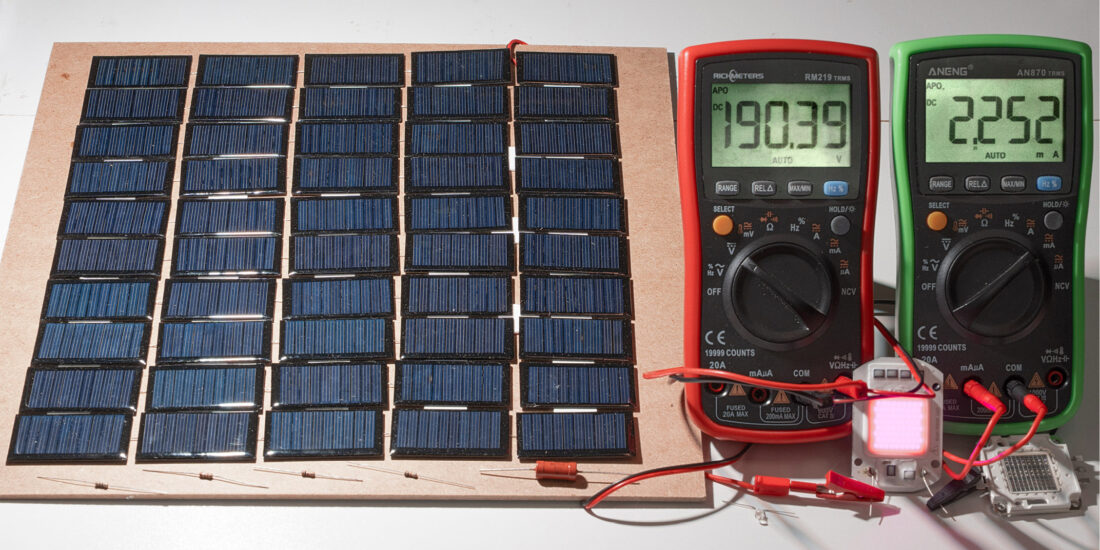

Pomiary

Prąd elektryczny to ruch, przepływ nośników (elektronów) i bardzo często interesuje nas wielkość, szybkość tego przepływu – czyli po prostu natężenie prądu elektrycznego, albo jak mówimy na co dzień w skrócie: prąd. Łatwo to zrozumieć intuicyjnie, a w analogii hydraulicznej chodziłoby o zmierzenie szybkości przepływu, np. w litrach na sekundę. Zakoduj sobie w głowie, że natężenie prądu wyrażane w amperach, to jedno z podstawowych pojęć elektroniki. Natężenie prądu, mierzy się amperomierzem. O ile hydraulicznym odpowiednikiem woltomierza jest miernik ciśnienia wody (manometr), o tyle na co dzień nie spotykamy hydraulicznych odpowiedników amperomierza. Nie daj się zmylić: liczniki zużycia wody, powszechnie spotykane w mieszkaniach nie są odpowiednikiem amperomierza, ponieważ pokazują sumaryczne zużycie wody w dłuższym odcinku czasu, natomiast odpowiednikiem amperomierza musiałby być przyrząd obrazujący chwilowy przepływ wody (w litrach na sekundę). Z kolei na co dzień nie spotykamy się z elektrycznymi odpowiednikami liczników zużycia wody – owszem są specjalistyczne przyrządy tego typu służące np. do pomiaru pojemności akumulatorów, ale to inny temat.

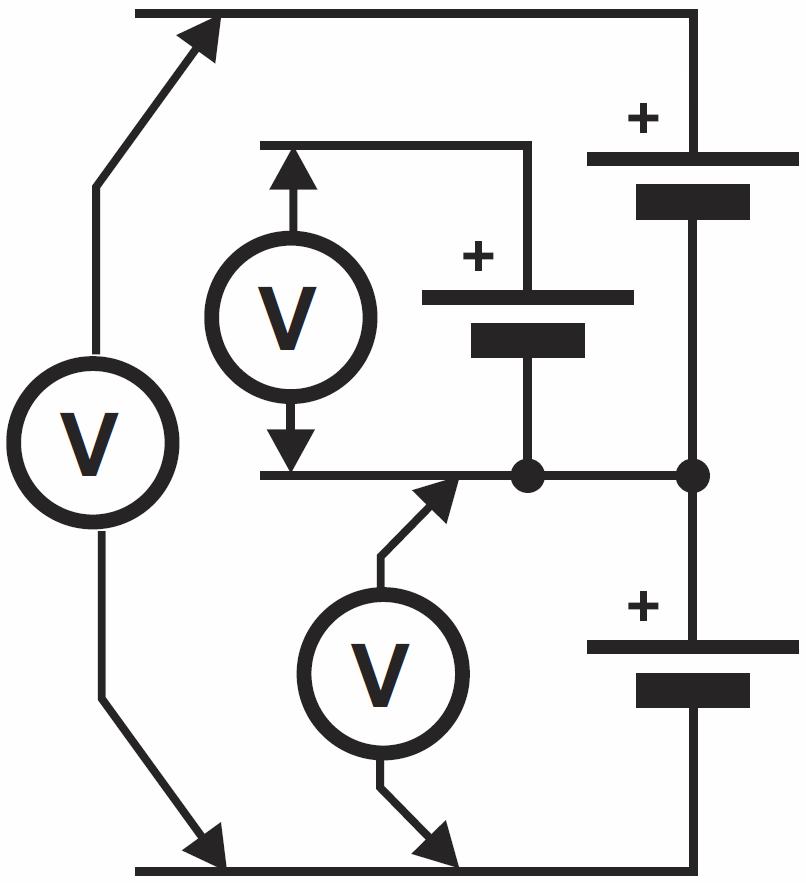

Woltomierz służący do pomiaru napięcia, czyli różnicy potencjałów dołącza się oczywiście do punktów, w których występują te potencjały – patrz przykład na rysunku 13.

Z kolei amperomierz służący do mierzenia natężenia (przepływu) prądu, koniecznie trzeba włączyć w obwód, w którym mierzymy prąd – patrz rysunek 14.

Wątpliwości…

Niejeden elektronik zestawia znane wzory: U×I = P = E/t

Pamięta z lekcji fizyki, że 1 dżul to „1 kilogram razy metr przez sekundę do kwadratu” i że 1 wat to jeden dżul na sekundę. Dowiedziawszy się że 1 W = 1 V × 1 A, zastanawia się, co wspólnego mają wolty i ampery z kilogramami, metrami i czasem…

Niektórzy dochodzą do wniosku, że wolty i ampery to coś „ściśle elektrycznego” nie mającego związku z mechaniką i że moc elektryczna to coś zupełnie innego niż moc w mechanice…

Taki wniosek jest z gruntu błędny. Wspólną płaszczyzną jest tu energia, czyli zdolność do wykonywania pracy. Po prostu energia może występować w różnej postaci. Wcześniej mówiliśmy, że napięcie to praca związana z przeniesieniem elementarnego ładunku elektrycznego z jednego potencjału do drugiego, natomiast prąd to po prostu ilość elementarnych ładunków przepływających w jednostce czasu.

Tym samym energia elektryczna, a także moc elektryczna (P=U×I), to taka sama zdolność do wykonania pracy, jak w przypadku energii mechanicznej, gdzie w grę wchodzą kilogramy i metry. Po prostu energia może mieć różną postać. Oprócz energii elektrycznej mamy takie choćby rodzaje jak: energię cieplną, mechaniczną, chemiczną czy jądrową. Co bardzo ważne energia nie może zginąć, natomiast bardzo często następuje zamiana jednej postaci energii w inną. I tak energia elektryczna może zamieniać się na mechaniczną (w silniku) i na odwrót: w prądnicy energia mechaniczna zamienia się w elektryczną. Energia elektryczna może zamieniać się w świetlną (żarówka, świetlówka, dioda LED, ekran monitora, telewizora), a odwrotny proces następuje w ogniwach słonecznych. W głośniku energia elektryczna zamienia się w energię mechaniczną (ruch membrany) i dalej na energię drgań cząstek powietrza (dźwięk). Z kolei w mikrofonie dynamicznym odwrotnie: energia dźwięku jest zamieniana w energię elektryczną. I wszystko byłoby pięknie, gdyby nie fakt, że nie potrafimy w doskonały sposób zamieniać jednej postaci energii w drugą.

Sprawność energetyczna

W silniku elektrycznym nawet 90% energii elektrycznej zamienia się na energię mechaniczną, ale już w żarówce mniej niż 10% energii elektrycznej zamienia się w światło, a w głośniku tylko około 1% dostarczonej energii elektrycznej zamienia się na energię dźwięku…

A co z resztą?

Otóż reszta nie ginie, tylko zamienia się w, można powiedzieć, „najmniej szlachetną” formę energii, a mianowicie na energię cieplną. Najczęściej ta zamiana części energii na ciepło jest wadą, ułomnością procesu konwersji. Dlatego często mówimy o sprawności energetycznej – wyraża ona w procentach, jaka część energii (mocy) zostaje przekształcona na pożądaną inną formę energii.

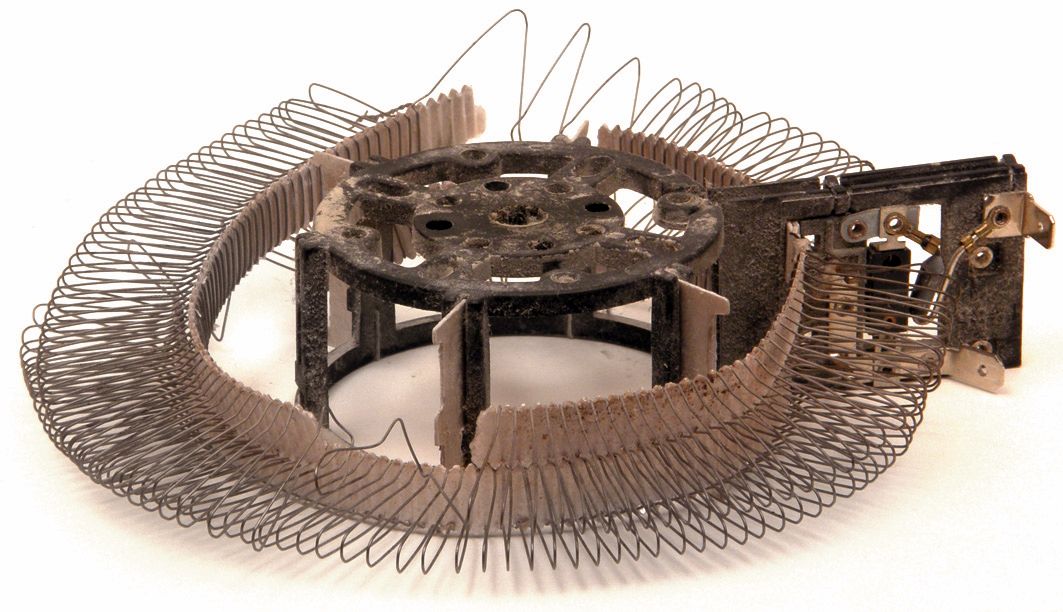

Tu trzeba wspomnieć o grzejniku elektrycznym, w którym energia elektryczna zamienia się na ciepło. W tym akurat przypadku celem jest zamiana na „najmniej szlachetną” energię cieplną i tylko w tym przypadku mamy do czynienia ze sprawnością 100%. Zapamiętaj – każdy grzejnik elektryczny ma sprawność 100%, czyli cała pobrana moc elektryczna (P=U×I) zamienia się na ciepło. I nie daj się oszukać: nie ma „nowoczesnych grzejników elektrycznych o wyższej sprawności”. Każdy, nawet najstarszy czy najtańszy piecyk elektryczny ma sprawność dokładnie 100%. Taką właśnie doskonałą sprawność ma także spirala ze starego, zepsutego grzejnika, pokazana na fotografii 15.

Jak już jesteśmy przy piecykach, warto wspomnieć, że klasyczne, najpopularniejsze wzmacniacze mocy audio, pracujące w tzw. klasie AB mają sprawność teoretycznie do siedemdziesięciu procent, ale w praktyce ogólna sprawność nie przekracza 50%. Oznacza to, że mniej więcej połowa mocy elektrycznej pobranej z sieci energetycznej zostaje doprowadzona do głośników, natomiast druga połowa zamienia się na ciepło. Najprościej mówiąc, 400-watowy wzmacniacz gitarowy podczas ciągłej pracy jest jednocześnie 400-watowym grzejnikiem. Nieprzypadkowo takie wzmacniacze są potocznie nazywane piecykami gitarowymi.

Jeszcze gorzej jest z audiofilskimi wzmacniaczami pracującymi w tzw. klasie A. Ich sprawność nie przekracza 10%, a może wynosić 5%. Sprawność 10% oznacza, że 90% pobranej mocy zamienia się na ciepło, czyli np. wzmacniacz o mocy 2×50 W (razem 100 W) byłby jednocześnie 90-watowym grzejnikiem. Powinieneś też wiedzieć, że nowoczesne wzmacniacze klasy D i klas pokrewnych mają sprawność nawet do 90%, czyli w 100-watowym wzmacniaczu tego rodzaju tylko około 11 W mocy zamieni się na ciepło.

Przetwarzanie analogowe i cyfrowe

W wymienionych właśnie elementach i układach zachodzi zamiana jednej postaci energii w inną. Nie umiemy robić tego doskonale, a miarą tej (nie)doskonałości jest sprawność energetyczna. A jak jest ze sprawnością w urządzeniach elektronicznych, gdzie nie zmieniamy postaci energii? Na przykład w przedwzmacniaczu audio, w korektorze czy regulatorze barwy dźwięku, przetwarzane sygnały i na wejściu i na wyjściu mają znikomą, pomijalnie małą moc. Celem nie jest zamiana energii, tylko modyfikacja sygnału – w tym wypadku przebiegu napięcia elektrycznego, reprezentującego dźwięk.

Śmiało możemy powiedzieć, iż np. filtr czy przedwzmacniacz mają sprawność energetyczną równą zeru. W takich urządzeniach praktycznie 100% mocy dostarczonej „marnuje się”, zamieniając się na ciepło. Warto przy tym pamiętać, że pełniący taką funkcję przedwzmacniacz, czy korektor lampowy może pobierać i rozpraszać w sumie kilkadziesiąt watów mocy. Natomiast tego rodzaju układ na wzmacniaczu operacyjnym spełni taką samą funkcję, pobierając i rozpraszając w postaci ciepła nie kilkadziesiąt, tylko np. 0,01 wata mocy.

A jaka jest sprawność energetyczna urządzeń cyfrowych, mikroprocesorów i komputerów?

Jak wcześniej analizowaliśmy, przetwarzają one coś niematerialnego i ulotnego – informacje. Informacje „wchodzące i wychodzące” nie mają nic wspólnego z energią. Cała moc elektryczna dostarczona do układu ze źródła zasilania zamienia się na ciepło. Tym samym sprawność energetyczna nawet najwspanialszych komputerów i mikroprocesorów jest… zawsze równa zeru.

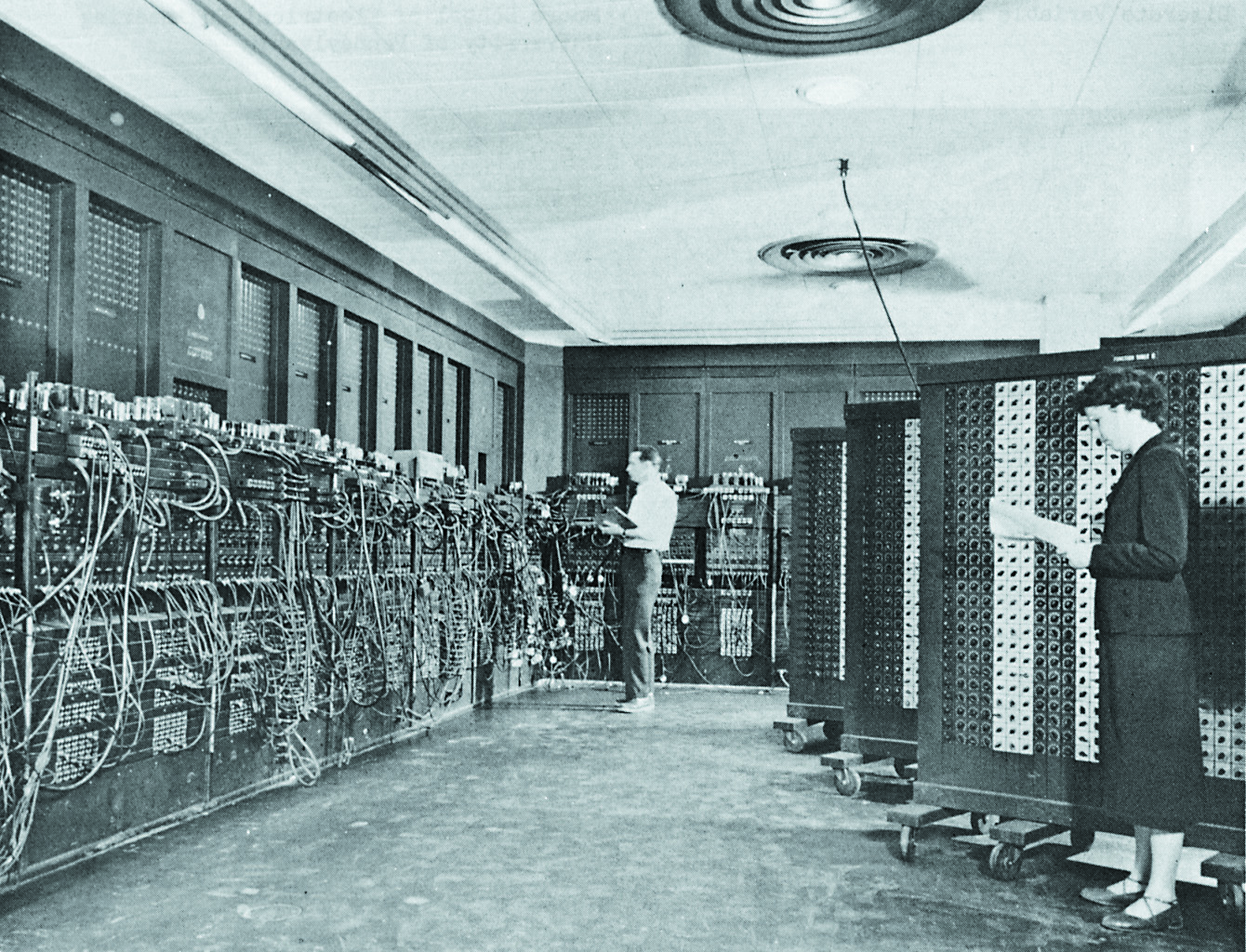

Czy wiesz, że pierwszym elektronicznym komputerem cyfrowym był ENIAC (skrót od Electrical Numerical Integrator And Calculator), ukończony w roku 1946. Elementami czynnymi były tam lampy elektronowe. Komputer ten był budowany w czasie II wojny światowej i służył do obliczeń balistycznych – torów lotu pocisków.

Jeśli wyobrażasz sobie ten pierwszy komputer jako dużą skrzynię, jesteś w wielkim błędzie. Eniac wyglądem zupełnie nie przypominał żadnego współczesnego komputera. Było to monstrum składające się z 42, ale nie skrzyń, tylko płaskich paneli rozmieszczonych na trzech ścianach dużego pomieszczenia – patrz fotografia 16. Każdy z paneli miał około 3 metrów wysokości, prawie metr szerokości i ok. 30cm głębokości. Na budowę tego potwora zużyto 17468 lamp elektronowych i tysiące innych elementów (przekaźniki, rezystory, kondensatory, przełączniki). Całość zajmowała powierzchnię prawie 170 m2 i ważyła 30 ton! Podczas pracy komputer pobierał ponad 160 kW energii – tyle ile zużywa wieczorem średniej wielkości miasteczko. Energia ta wydzielała się w postaci ciepła i trzeba było zastosować bardzo skuteczny system wentylacji i chłodzenia pomieszczenia, które zajmował ten komputer. Ta potężna maszyna dokonywała do 5000 operacji dodawania, albo 357 operacji mnożenia w ciągu sekundy…

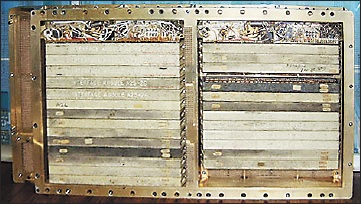

Warto też wiedzieć, że w ramach kolejnych misji Apollo, które w latach 60. XX wieku doprowadziły człowieka na Księżyc, wykorzystywano pierwsze komputery zbudowane na układach scalonych. Taki kosmiczny komputer zawierał 4100 prostych układów scalonych oraz prymitywną pamięć na maleńkich pierścionkach magnetycznych. Ważył ponad 30 kg i pobierał ponad 50 W mocy – patrz fotografia 17.

A dziś?

Współczesne domowe komputery są tysiące, a nawet miliony razy szybsze – niektóre dokonują kilku miliardów operacji matematycznych na sekundę, ważą kilka kilogramów i zużywają 100…200 watów energii. Obecnie za kilka złotych każdy może kupić mikrokomputer, inaczej mikroprocesor – małą kostkę do której zasilania wystarczy jedna maleńka bateryjka. Taka niepozorna kostka potrafi dokonywać obliczeń tysiące razy szybciej niż ENIAC. Jeśli masz kalkulator, który oprócz podstawowych operacji potrafi obliczać logarytmy i funkcje trygonometryczne, to Twój sprzęt ma znacznie lepsze możliwości i zużywa nieporównanie mniej energii, niż „kosmiczne komputery” które kontrolowały statki kosmiczne Apollo i ich księżycowe lądowniki.

Patrząc z innej strony, Twój nowoczesny komputer jest też przy okazji grzejnikiem elektrycznym o sprawności 100%. To znaczy, że cała pobrana z sieci energia ostatecznie zamienia się w nim na ciepło. Z Twoim monitorem jest odrobinę inaczej – to też jest grzejnik elektryczny, ale o sprawności nieco niższej od 100%, ponieważ malutka część energii pobranej z sieci zamienia się na światło emitowane z ekranu. Podobnie zestaw audio z głośnikami jest w sumie grzejnikiem elektrycznym o sprawności powyżej 99%, ponieważ tylko znikoma część pobranej energii zamienia się na energię akustyczną.

Nie ulega więc wątpliwości, że celem postępu jest przetwarzanie „jak najmniejszym kosztem” niematerialnego sygnału – informacji, jak też dokonywanie przemian jednego rodzaju energii w drugą przy jak najmniejszych stratach cieplnych. I tu dochodzimy do kolejnego ważnego problemu praktycznego.

Problem ciepła

Generalnie staramy się, żeby takie urządzenia elektroniczne pobierały jak najmniej mocy (P=U×I) i żeby jak najmniej mocy zamieniało się na ciepło. Od razu warto podkreślić, że najczęściej wcale nie chodzi o oszczędności w opłatach za energię elektryczną. We współczesnych miniaturowych urządzeniach zasilanych bateryjnie istotnym celem na pewno jest jak najdłuższa praca bez konieczności wymiany baterii czy ładowania akumulatora. Okazuje się jednak, że w wielu wypadkach chodzi o coś jeszcze innego: o słabo rozumiany i niedoceniany przez początkujących problem ciepła, a ściślej problem temperatury.

Chyba nie masz wątpliwości, że wydzielenie się w elemencie energii cieplnej oznacza wzrost temperatury. Energia elektryczna zamienia się na ciepło (na energię cieplną) w elementach układu, a potem wytworzone ciepło w całości jest odprowadzane do otoczenia – ilustruje to rysunek 18.

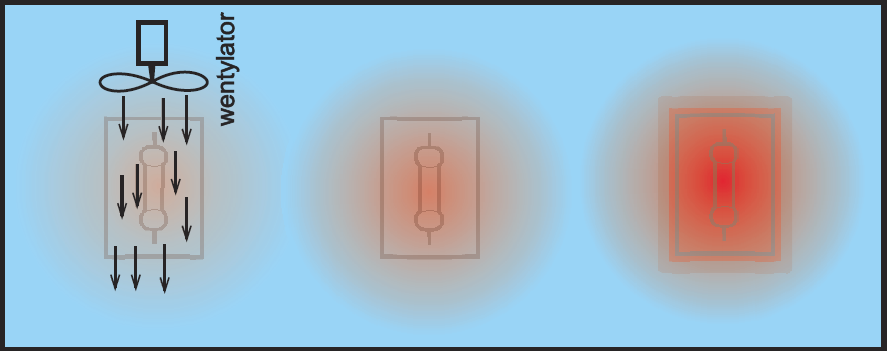

W szczegóły nie musisz wchodzić, ale musisz zrozumieć podstawową zależność: otóż moc strat wyrażona w watach nie przekłada się jednoznacznie na wzrost temperatury w stopniach Celsjusza, ponieważ w grę wchodzą także warunki chłodzenia. Zawsze ciepło wytworzone w danym elemencie musi zostać rozproszone do otoczenia. Gdy ciepło może bez większych przeszkód przejść z elementu do otoczenia, wtedy temperatura elementu wzrośnie niewiele. Jeśli natomiast przepływ ciepła napotyka jakieś przeszkody, wtedy temperatura pracującego elementu wzrasta na tyle, żeby „przepchnąć” ciepło przez przeszkodę do otoczenia. Rysunek 19 pokazuje trzy przykłady, gdzie taka sama jest moc strat wydzielanych w postaci ciepła. W pierwszym przypadku wentylator zapewnia znakomite chłodzenie, więc temperatura wzrośnie niewiele. W trzecim przypadku izolująca obudowa utrudnia odprowadzanie ciepła. W efekcie temperatura układu poważnie wzrasta. W każdym z tych trzech przypadków wytwarza się taki stan równowagi termicznej, żeby na bieżąco „wypchnąć” całe wytwarzane ciepło do otoczenia.

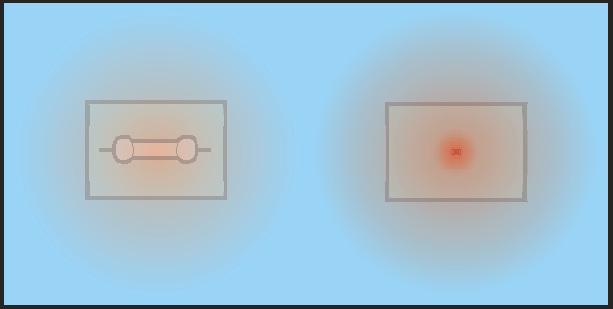

Temperatura grzejącego się elementu zależy od warunków oddawania ciepła do otoczenia, czyli też od rozmiarów, a ściślej od powierzchni oddającej ciepło. Generalnie czym większy element (większa powierzchnia), tym łatwiej odprowadza ciepło do otoczenia. Oczywiście mały element może rozproszyć taką samą ilość ciepła jak duży, jednak będzie miał wyższą temperaturę, jak wskazuje na to rysunek 20.

Tu trzeba wyraźnie podkreślić, że w elektronice jednym z kluczowych problemów jest wzrost temperatury. Otóż krzemowe struktury półprzewodnikowe, w tym tranzystory i układy scalone łącznie z mikroprocesorami, mogą pracować w temperaturach do +150°C, najwyżej +175°C. W wyższej temperaturze krzem nie stopi się, nie ma też ścisłej granicy uszkodzenia – po prostu w wyższych temperaturach gwałtownie rosnąć będzie ryzyko awarii elementu. Dlatego powszechnie przyjmuje się maksymalną temperaturę pracy struktury półprzewodnikowej równą +150°C. W urządzeniach elektronicznych trzeba zapewnić takie warunki pracy i chłodzenia elementów, żeby temperatura półprzewodników nie przekroczyła tych +150°C. To jest bardzo szeroki i niełatwy problem praktyczny, przed którym stają konstruktorzy. Na razie nie musisz znać szczegółów, ale od początku powinieneś rozumieć zarys problemu ciepła i temperatury.

W następnym odcinku zajmiemy się głównie rezystorami. Choć są to najpopularniejsze, najtańsze i wydawałoby się, najprostsze elementy, prawdopodobnie będziesz zaskoczony niektórymi informacjami na ich temat.

Piotr Górecki